| HIFI-FORUM » Stereo » Elektronik » CD-/SACD-Player & andere digitale Quellen » Wie viel Sinn machen 32 Bit, 192 kHz und 384 kHz? | |

|

|

||||

Wie viel Sinn machen 32 Bit, 192 kHz und 384 kHz?+A -A |

||||||||||

| Autor |

| |||||||||

|

pelmazo

Hat sich gelöscht |

#101

erstellt: 06. Nov 2012, 14:10

|

|||||||||

Es wird auf die 147-fache Abtastrate interpoliert und dann um den Faktor 160 dezimiert. |

||||||||||

|

Joe_M.

Stammgast |

#102

erstellt: 06. Nov 2012, 14:34

|

|||||||||

|

Verstehe ich das jetzt richtig: Das Signal wird auf 16 Bit / 7056 KHz hochgerechnet?!? Gibt es dazu einen Standardalgorithmus? Ich überlege schon seit meinem ersten Post, wie ich das umsetzen würde, aber Ich wüsste zur Zeit nicht, wie ich das machen würde... Das Hochrechnen ist nicht das Problem, aber das Zusammenfassen der 160 (Daten-)Worte zu einem einzelnen Wort. Wird hier tatsächlich gerechnet, oder einfach nur die statistische Mehrheit übernommen? In diesen 160 Worten können ja nur zwei verschiedene Worte auftauchen. |

||||||||||

|

|

||||||||||

|

pelmazo

Hat sich gelöscht |

#103

erstellt: 06. Nov 2012, 14:48

|

|||||||||

Im Prinzip ja. Hört sich aufwändig an, ist aber nicht so drastisch, denn die meisten der Werte würde man im nächsten Schritt sowieso wieder wegschmeißen. Das kann man ausnutzen, um Rechenarbeit zu sparen.

Die Methode ist recht klar, aber die Einzelheiten können variieren, wie z.B. die Wortlänge mit der gerechnet wird, und der Tiefpaß, der benötigt wird, um Aliasing zu vermeiden.

Wenn die Bandbreite auf unter 22 kHz begrenzt wurde, dann schmeißt man von den 160 Werten einfach 159 weg. Oder rechnet sie gar nicht erst aus. Es gibt Literatur zu diesen Dingen, die ist ggf. aber recht mathematiklastig. Ein inzwischen 30 Jahre alter Klassiker ist "Multirate digital signal processing" von Crochiere/Rabiner. |

||||||||||

|

Hörschnecke

Inventar |

#104

erstellt: 06. Nov 2012, 18:39

|

|||||||||

Pelmazo beim Wort genommen und etwas salopp ausgedrückt werden jeweils 146 Samples zwischen zwei ursprünglichen erraten. Dann werden alle vorhandenen Signalbestandteile, die im Original größer als 22050 Hz waren, nach Möglichkeit mit mehr oder weniger geeigneten Filtern ausgesiebt (erster Informationsverlust). Aus dieser neuen Folge von 99,3% erfundenen Samples wird dann wieder jedes 160-ste herausgepickt. Im "downgesampelten" Ergebnis sind am Ende also nur noch etwa 8% der ursprünglichen Originalsamples enthalten, wenn ich nicht irre (zweiter Informationsverlust). [Beitrag von Hörschnecke am 06. Nov 2012, 18:40 bearbeitet] |

||||||||||

|

Burkie

Inventar |

#105

erstellt: 06. Nov 2012, 18:54

|

|||||||||

|

Hörschnecke, Du verstehst es nicht. Es ist hoffnungslos mit Dir. Wenn Du wengistens nicht dauernd versuchen würdest, pelmazo ans Bein zu pinkeln. Es werden überhaupt keine Samples erraten. Es werden Null-Werte eingesetzt. Anschließend geht das ganze durch ein Tiefpass, der das Frequenzband wieder auf das ursprüngliche bzw., beim Downsampling, auf den Bandbereich der Zielrate begrenzt. Mathematisch gesehen ein Interpolations..- ach, verstehst Du eh nicht. Anschließend wir das digitale Signal softwaremässig mit der niedrigen Zielrate abgetastet. Planmässig ist die hohe Zwischenrate ein ganzzahliges Vielfache der Zielrate. Man braucht also nur jedes einhundert-irgendwas-fache Sample nehmen und alle anderen verwerfen. Et voila, das Signal steht in der Zielrate zur Verfügung. Informationsverlust gibt es nur, falls downgesamplet wird, aber das versteht sich von selbst. Eine niedrigere Samplerate kann nicht den Bandbereich einer höheren Samplerate enthalten. Beim Upsamplen gibt es keinen Informationsverlust. Grüße [Beitrag von Burkie am 06. Nov 2012, 19:19 bearbeitet] |

||||||||||

|

Burkie

Inventar |

#106

erstellt: 06. Nov 2012, 19:02

|

|||||||||

|

Ergänzung: In die Zielrate dürfen vor allen Dingen nicht einfach irgendwelche Samples der Originalrate übernommen werden. Würde man das machen, also z.B. beim downsamplen einfach die ersten soundsoviel Samples nehmen, und dann eines auslassen, dann wieder soundsoviele nehmen, dann wieder eines auslassen, usw. Dann hätte man zwar viele Originalsamples im Zielsignal, es würde aber "stottern". Beim downsamplen würde man dann also die ersten soundsoviel Samples der Originalrate mit zu niedriger Rate (der Zielrate, die aber "langsamer" ist als die Originalsamplerate) abspielen, dann eines auslassen, wenn der zeitliche Verzug gerade eine "Samplezeit" ausmachen würde. So darf es also nicht gehen. Grüße |

||||||||||

|

Jeck-G

Inventar |

#108

erstellt: 06. Nov 2012, 19:07

|

|||||||||

|

@Hörschnecke: Dass Interpolation sehr gut funktionieren kann, sehe ich tagtäglich an CNC-Maschinen. Wenn der Fräser (oder Drehmeißel) eine schräge Kontur fährt, so ist das für uns eine gerade Linie (fahre von X0 X0 nach X65 Y27), aber die Steuerung muss tausende Zwischenpunkte in Echtzeit berechnen, Soll/Istwete vergleichen (Istwerte kommen vom Wegmessystem) und die Servomotoren dementsprechend ansteuern und das mit der richtigen, im Programm vorgegebenen Geschwindigkeit. Bei Rundungen (Radien/Kreise, Ellipsen) wird es noch schlimmer und oft werden auch 3 Achsen (oder mehr) gleichzeitig verfahren. Die Länge und der Radius vom Werkzeug muss ebenfalls mit verrechnet werden. Und Du kommst hingegen mit solchem popeligen Krams...  [Beitrag von Jeck-G am 06. Nov 2012, 19:11 bearbeitet] |

||||||||||

|

Burkie

Inventar |

#109

erstellt: 06. Nov 2012, 19:17

|

|||||||||

|

Zweite Ergänzung: Anstatt nun bei der Sampleraten-Wandlung viele Samples der hohen Zwischensamplerate über Tiefpassfilterung zu berechnen, von denen die meisten dann bei der Dezimation ohnehin wieder verworfen werden, könnten intelligente Algorithmen nur die letzlich benötigten Samples der Zielrate berechnen. Diese intelligenten Algorithmen bringen weder was für die Genauigkeit noch für den Informationsverlust. Sie machen die Ratenwandlung nur schneller oder weniger speicherintensiv. Die Information steckt übrigens nicht in den Samples an sich, sondern in den Samplewerten im Zusammenhang mit der zeitlichen Abfolge (Samplerate). Wird die Samplerate gewandelt, z.B. upgesamplet, kann die ganze Information erhalten bleiben. Sie wird aber durch vordergründig (für den Laien) komplett andere Samplewerte repräsentiert, da ja auch die zeitliche Abfolge eine andere ("schnellere") geworden ist. Die Darstellung digitalisierter Audiosignale als Treppenstufen-Kurve in Audioeditoren ist extrem misleading für den Laien. Sie dient dem Ton-Ing. nur dazu, etwa zwei Aufnahmen/Takes zeitlich möglichst genau auf einander anzulegen, etwa beim Schnitt. Grüße |

||||||||||

|

Jeck-G

Inventar |

#110

erstellt: 06. Nov 2012, 19:56

|

|||||||||

Also quasi so, als würde man sich ein analoges Signal am Oszi ansehen... |

||||||||||

|

Joe_M.

Stammgast |

#112

erstellt: 06. Nov 2012, 22:00

|

|||||||||

|

@pelmazo: Mathematischer darf's ruhig werden... Davon verstehe ich zumindest was...  Danke für den Tipp, nur ist mein Englisch mittlerweile ziemlich eingerostet. Hast Du vielleicht noch eine Buchempfehlung auf Deutsch? Grüße Joe |

||||||||||

|

Burkie

Inventar |

#113

erstellt: 06. Nov 2012, 22:36

|

|||||||||

Ich finde so eine Darstellung für Laien extrem missverständlich. Man sieht dort Treppenstufen, die in echt, wenn das Signal DA-gewandelt ist, einfach nicht mehr da sind. Für die Audio-Bearbeitung ist so eine Darstellung für diejenigen, die damit umgehen können, sinnvoll. Aber gleichwerig wäre auch eine Darstellung, wo zu den Samplezeiten einfach nur ein Punkt am Samplewert gezeichnet wäre. Oder nur ein senkrechter Strich zum Samplewert gezeichnet wäre. @pelmazo: Ich will hier nur über die Technik diskutieren, und hoffentlich was dazu lernen. Ich habe versucht, die Darstellung der hörschnecke nach bestem meinem Wissen und möglichst anschaulich für Laien ohne zuviel Korrektheit zu verlieren, zu korregieren. Gewisse mehr oder weniger diplomatische Anmerkungen befinden sich im Text, und wer zwischen den Zeilen lesen kann.... Wer das nicht will und einfach nur den lauter vorgebrachten Scheinargumenten glauben will, dem ist eh nicht zu helfen... Aber das ist nicht unsere Zielgruppe... Und ich denke, damit könnten wir es gut sein lassen. Ich freue mich über jede Korrektur meiner Darstellung durch kompetente Poster. Grüsse [Beitrag von Burkie am 06. Nov 2012, 22:44 bearbeitet] |

||||||||||

|

_ES_

Administrator |

#114

erstellt: 06. Nov 2012, 22:50

|

|||||||||

Laien sind die meisten von uns, was das Thema betrifft. Wiki und ein paar andere Internet-Quellen lesen macht kein Experte aus, hoffe ich doch mal. Ansonsten wäre deren Ausbildung für den Popo, wenn es so einfach ginge..

Sagt wer..? Das ist gar nicht mal so einfach, von wahr und unwahr zu unterscheiden, was hier so gepostet wurde. Die Stile vermischen sich zu sehr, wer da nicht sowieso etwas vorbelastet ist, kann das Problem bekommen, genauso schlau wie vorher zu sein. Was allerdings immer punkten würde, wäre eine neutrale, personenunabhängige Betrachtung der Sache. Die erkennt fast jeder..  |

||||||||||

|

AndreasHelke

Stammgast |

#115

erstellt: 06. Nov 2012, 22:52

|

|||||||||

|

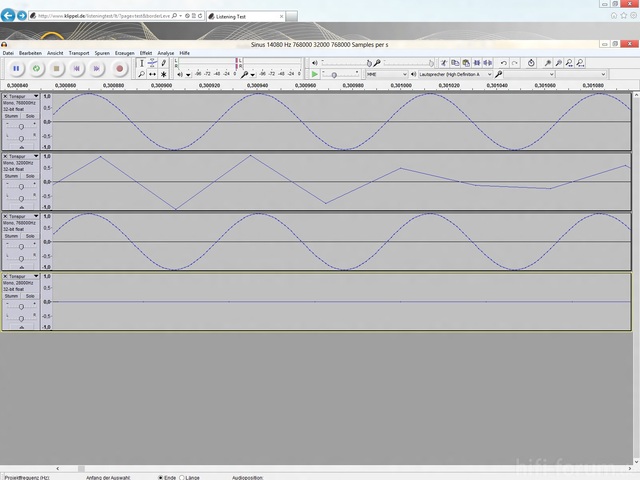

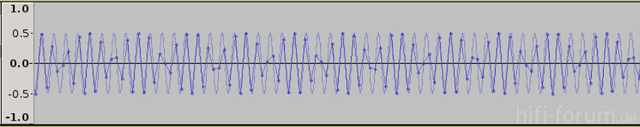

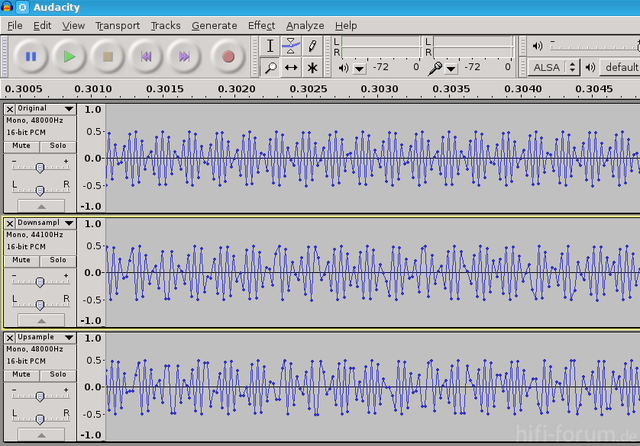

Deshalb habe ich in Audacity ein Sinussignal mit 784 kHz Samplerate erzeugt. Dann auf 32 kHz heruntergerechent. Und anschliesend das 32 kHz Signal wieder auf 784 kHz umgerechnet. Die Kurve des 784 kHz Signals ist dann schon eine recht gute Annäherung an das fast identische Analogsignal das der DAC aus allen 3 Dateien produziert.  Dieses Bild gibt es schon einmal in dieser Diskussion. Aber einige der jetzigen Diskussionsteilnehmer und Leser brauchen anscheinen noch einmal eine Erinnerung. Die meisten Leute die versuchen Digitalauzeichung anschaulich darzustellen versäumen leider das Analogsignal zu zeigen, das am ende der Aufnahme und Wiedergabekette entsteht. [Beitrag von AndreasHelke am 06. Nov 2012, 22:53 bearbeitet] |

||||||||||

|

Jeck-G

Inventar |

#116

erstellt: 06. Nov 2012, 23:04

|

|||||||||

|

AndreasHelke

Stammgast |

#117

erstellt: 06. Nov 2012, 23:09

|

|||||||||

|

Das sieht nach einem Spline aus. Audacity hat leider nur Geraden im Angebot um die Samplepunkte zu verbinden. |

||||||||||

|

pelmazo

Hat sich gelöscht |

#118

erstellt: 06. Nov 2012, 23:53

|

|||||||||

Da wird's deutlich dünner. Auch deutsche Autoren schreiben solche technischen Bücher oft auf Englisch. Ich habe noch ein Buch von Fliege, das ist zwar auf Englisch, aber darin steht es sei die Übersetzung eines deutschen Werkes von 1993: "Multiraten-Signalverarbeitung". Vielleicht ist das noch zu kriegen.

Das kann ich nachvollziehen, und mir wäre es selber lieber, wenn man einfach über Technik diskutieren könnte. Ich bin allerdings nicht überzeugt, daß der Versuch Erfolg verspricht, einen Teilnehmer wie Hörschnecke dadurch zu korrigieren, daß man diplomatisch und zwischen den Zeilen schreibt. Es ist natürlich eine Frage der Zielgruppe, aber ich wäre nicht so überzeugt, das Scheinargumente auch als solche erkannt werden, und zwar umso weniger je sporadischer und oberflächlicher die Leute teilnehmen. Der Thread hier ist aber zugegebenermaßen nicht der Maßstab, da ist es ziemlich offensichtlich. Insofern stimme ich R-Type zu wenn er meint: "Das ist gar nicht mal so einfach, von wahr und unwahr zu unterscheiden, was hier so gepostet wurde." (in der Annahme er meint damit nicht nur diesen Thread, sondern das Forum im Ganzen) Ich kann aber gar nicht nachvollziehen, wie man das dann am Stil festmachen kann. Ich bin überzeugt, daß wahr und falsch mit dem Stil gar nichts zu tun hat, und daß es sogar geradezu kontraproduktiv ist, sich bei der eigenen Wahrheitsfindung am Diskussionsstil zu orientieren. Die Wahrheit ist weder nett noch bequem, und der Anspruch sie müßte leicht verdaulich und unoffensiv daher kommen, setzt komplett falsche Schwerpunkte. Ich bin immer noch der Meinung, daß man besser Klartext redet als sich in diplomatische Verrenkungen zu ergehen, und daß der Keil zum Klotz passen muß. Leider sehen das auch einige Moderatoren hier ganz anders, was ich für einen Fehler halte, weil dadurch meiner Meinung nach im Ergebnis die Hinterfotzigkeit belohnt, und die ehrliche Geradlinigkeit bestraft wird.

Es gibt Audio-Editoren, die es richtig machen. Audacity macht es falsch. Das wurde auch schon als Bug oder Wunsch angemahnt, aber die Programmierer hatten kein Interesse daran was zu ändern. Es wäre gar nicht so schwierig, denke ich, denn letztlich ist die Darstellung als Kurve auf dem Bildschirm auch nichts anderes als eine Abtastratenwandlung, denn die Pixel sind ebenfalls so etwas wie Abtastzeitpunkte. Da ein Abtastratenwandler in Audacity vorhanden ist, hätte man den einfach hierfür einspannen können. |

||||||||||

|

Hörschnecke

Inventar |

#119

erstellt: 07. Nov 2012, 20:31

|

|||||||||

|

"Wie wird das überhaupt von 48 auf 44,1 gewandelt?" war zur Erinnerung die Frage eines Teilnehmers. und pelmazo hatte darauf geantwortet "Es wird auf die 147-fache Abtastrate interpoliert und dann um den Faktor 160 dezimiert." Burkie widerspricht pelmazo: "Es werden überhaupt keine Samples erraten." und leugnet damit Interpolation bei dem Szenario.

Was denn nun? Das Originalsignal kann im Szenario Frequenzen bis 24kHz enthalten haben und wenn Du nur bis dahin tiefpassfilterst, machst Du einen Fehler beim Abtasten auf die Zielrate von 44,1kHz. Tiefpassfilterst Du hingegen gleich bis 22,05kHz, hast Du einen unwiederbringlichen Informationsverlust, wenn das höherwertige 48kHz-Original-Sample zuvor seine gesamte Bandbreite ausgenutzt hatte. Wenn Du also anschließend mit "der niedrigen Zielrate abgetastet", im Szenario 44,1kHz, filterst Du tunlichst auf 22,05kHz Bandbreite.

... das ist nicht nur ungefähr "jedes einhundert-irgendwas-fache Sample", sondern eben jedes 160-ste Sample, das Du aufbewahrst. Eben aufgrund der Ganzzahligkeit von Sample-Folgen wurde hier das kleinste-gemeinsame-Vielfache mit 160 und 147 ausgewählt.

... sagte ich doch, schließlich handelt es sich im Szenario um ein Downsampling von 48 auf 44,1kHz.

... und wie ist das beim Upsampling auf die 147-fache Zielrate? Ist dann nicht jedes 147-ste Sample doch ein "Original-Sample"? und somit 99,3% interpolierte, also mehr oder weniger elaboriert erratene Fremd-Samples? Oder sind Deiner Meinung nach 100% der Samples in der 147-fachen Zielrate nicht mehr original, denn Du behauptest ja, es dürfen keine "Samples der Originalrate" in die Zielrate übernommen werden??

... wie kommst Du denn auf diesen Unsinn? Ich habe hier die ganze Zeit vom genauen Gegenteil geschrieben, nämlich daß man beim downsampling allenfalls immer einzelne gemaß einer Folge "herauspickt" (und eben nicht irgendwelche cluster).

Wieso sollte Interpolation nicht gut funktionieren können?? Das ändert aber nichts daran, daß es nur eine mehr oder weniger gute Form von elaboriertem Raten ist, wenn eine Samplefolge keine vorhersagbare Periodizität hat. Dieser Fehler wird hier von bestimmten Leuten immer wieder begangen, daß sie Wertungen und nüchterne Sachlage nicht auseinander halten (können?).

... richtig, aber das sollte man eher denen ins Heft schreiben, die glauben, daß alles nur 0 und 1 sei und damit erledigt. Die Genauigkeit des Faktors Zeit spielt bei allen digital-analogen Wandlungen eine gleichberechtigte Rolle und damit unterscheidet sich das Echtzeitmedium Audio nunmal entscheidend von der asynchronen Festplatte. @ AndreasHelke Das wiederholte Posten Deiner wenig aussagekräftigen Grafik ist wiederholt mit Fehlern durchsetzt, korrigiere bitte die Sampleraten, wenn Du das Forum nicht erneut verwirren möchtest.

... ein spline "macht es auch falsch". Jede Art Verbindungslinie in einer Bilddarstellung von Audio-Samples ist "falsch", denn wir kennen nur die losen Samples wirklich. [Beitrag von Hörschnecke am 07. Nov 2012, 20:53 bearbeitet] |

||||||||||

|

drSeehas

Inventar |

#120

erstellt: 07. Nov 2012, 21:02

|

|||||||||

Hörschnecke, du scheinst ein hoffnungsloser Fall zu sein... Burkie widerspricht nicht pelmazo, sondern dir. Interpolieren != erraten. Wenn du das anders siehst: dein Problem.  https://de.wikipedia.org/wiki/Interpolation_(Mathematik) https://de.wikipedia.org/wiki/Interpolation_(Mathematik)  https://de.wikipedia.org/wiki/Nyquist-Shannon-Abtasttheorem https://de.wikipedia.org/wiki/Nyquist-Shannon-AbtasttheoremOb Burkie Interpolation leugnet oder nicht, soll er selbst schreiben. Zum Rest schreibe ich nichts mehr... [Beitrag von drSeehas am 07. Nov 2012, 23:32 bearbeitet] |

||||||||||

|

Jeck-G

Inventar |

#121

erstellt: 07. Nov 2012, 23:00

|

|||||||||

Mit Raten hat Interpolieren (hier: Zwischensamples, CNC-Maschinen, CAD-Systeme) absolut nichts zu tun, sondern diese sind errechnet. Wenn die CNC-Fräse die Zwischenwerte erraten würde, so müsste ich es an der Oberfläche sehen können. Aber dafür ist die Fläche zu gut und die Kante zu gerade... Und jetzt beweise (zur Not mit vernünftigen Quellenangaben), dass dies nicht stimmt. |

||||||||||

|

Hörschnecke

Inventar |

#122

erstellt: 08. Nov 2012, 21:52

|

|||||||||

... das wurde in den letzten Beiträgen von unterschiedlichen Personen mindestens zweimal genannt: Man stellt allein die zeitdiskreten Samples graphisch dar.

... beim Dezimieren geht Information über die genaue Position der ursprünglichen Samples unwiederbringlich verloren und diese Unschärfe führt dazu, daß die Position der Ziel-Samples bei der geringeren Abtastrate ebenfalls nur noch mit einer gewissen Unschärfe abgeschätzt werden kann. Dies Abschätzung ist, wenn auch recht genau, eine elaborierte Form von Raten - wie ich nicht ohne Grund ausdrücklich mehrfach so eingeschränkt formuliert habe.

... eine gute Quelle war Dir zwei Stunden vorher bereits geboten worden, Du kannst lesen. |

||||||||||

|

Burkie

Inventar |

#123

erstellt: 08. Nov 2012, 22:04

|

|||||||||

Genauso muss es wohl sein. Du hast Recht, und nun lass uns unsere Ruhe. |

||||||||||

|

Burkie

Inventar |

#124

erstellt: 08. Nov 2012, 23:21

|

|||||||||

|

Hallo, ich denke, zur Sampleraten-Wandlung ist ja besonders dank Hörschneckens Ausführungen und Erklärungen nun alles gesagt. Kommen wir wieder auf die Impulse und die Filter zurück. Ideale Impulse, bei denen etwa die Spannung oder der Luftdruck schlagartig ohne jeglichen Zeitverzug von einem auf den anderen Wert hoch geht, kann es in echt nicht geben. Ideale Impulse sind z.B. Rechteck-Funktionen. Warum nicht? Betrachtet man sich das Frequenzspektrum, kommen Frequenzen von null bis unendlich vor. Die erforderliche Leistung ginge gegen unendlich. Reale Impulse sind somit immer bandbreitenbegrenzt, also mit Pre- und Post-Ringing ausgestattet. Wir betrachten ja hier akustische Ereignisse, die digitalisiert und aufgenommen werden sollen. Ideale Impulse wären hierbei ein schlagartiger Luftdruckanstieg, in der Zeitdarstellung also senkrechte Ausschläge nach oben (oder unten). So etwas findet man schon in der Natur nicht. Zweitens muss man betrachten, was das Ohr hören, also darstellen kann. Das Ohr übertägt mehr oder weniger nichts oberhalb 16~20kHz, mit einem wohl mehr oder weniger steil oder flach einsetzendem Abfall beginnend ab um ca. 14kHz. Das Ohr ist also selber schon ein Tiefpass. Das bedeutet also, dass das Ohr selber selbst ideale Impuls, gäbe es sie denn, nur mit Pre- und Post-Ringing aufnehmen würde. Für eine realistische Wiedergabe ist es meiner Intuation nach nur wichtig, dass im Hörbereich, den sie durchlassen sollen, die Anti-Alias-Filter phasenlinear arbeiten. Das ist aber auch nur eher akademischer Natur. Denn echte Musikintrumente haben viel zahmere Impulse. Bei denen schwingt alles schön "langsam" ein. Von daher denke ich, dass im Hörbereich phasenlineare Filter das Optimum darstellen, denn was frequenzmässig ausserhalb der Hörbereichs passiert, kann das Ohr ohnehin nicht wahrnehmen. Grüße |

||||||||||

|

H_Schütte

Ist häufiger hier |

#125

erstellt: 09. Nov 2012, 10:22

|

|||||||||

|

Bei einer reinen Smaplingfrequenz Wandlung durch Interpolation, würde sich die Fehler verdoppeln, die durch die Pasenlage des Sampels zum Nutzsiganl enstehen. Beispielsweise ein 20 KHz Ton der mit 44,1 Khz abgetastet wird, kann nicht einen konstanten Pegel wirklcih abbilden den mal samplet man den Nuldurchgang, mal das Pegelmaximum des Nutzsiganls. So wird´ein ständig im Pegel schwankendes Signal digital fetgehalten, was nicht dem Originalsignal entspricht. Um diesen Fehler beim Wanden von Disgital zu Analog auszugleichen, ist es notwendig die Samplinginformation ause einen Zeitfenster zu betrachten, um so diesen Schwankungen entgegen wirken zu können. Und je tiefer solch ein Digitalfilter ist, desto größer ist das Zeitfenster, welches zu Filterung heran gezogen wird. Dies hat leider den eEbeneffekt, dass ein einzelner Impuls Vor- und Nachechos bekommt, und dieser einzelne Impuls zu einem gewissen Teil gedämpft wird. Diese Fehler kann man nur mit einer hohen Abstastfrequenz begegnen, die mindestens in der Lage ist, 4 Punkte eine Nutzschwingung zu erfassen, also die 4 fache Abtastfrequenz des Nutzsignals ware nötig, damit ein Digitalfilter nicht in dieser Tiefe benötigt wird, und weniger Samples zur gleichen Zeit betrachten muss. Und deswegen machen 96 KHz Abtastrate für mich einen großen Sinn, und führt zu einen wesentlich Impustreueren WIdergabe. |

||||||||||

|

cr

Inventar |

#126

erstellt: 09. Nov 2012, 12:03

|

|||||||||

|

Das stimmt überhaupt nicht, laut dem Shannon Theorem kann man natürlich mit 44 kHz ein konstantes 20 kHz Signal (ist de facto bandbegrenzt!) so abbilden, dass keinerlei Informationsverlust entsteht. Und jede Test CD, die einen 20 kHz-Sinus drauf hat (egal ob errechnet oder aus einem analogen Sinus erzeugt), beweist es. |

||||||||||

|

lumi1

Hat sich gelöscht |

#127

erstellt: 09. Nov 2012, 12:15

|

|||||||||

|

Es gibt  zwei Seiten, eine davon, , neben 1000en anderen, u.a. zwei Seiten, eine davon, , neben 1000en anderen, u.a.  die hier, welche die Thematik ziemlich eindeutig behandeln. die hier, welche die Thematik ziemlich eindeutig behandeln.Weiterhin schreiben sich hier ca. drei Leute die Finger wund. Und sie schreiben es so leicht verständlich, dass es sogar "einer" wie ich, der in seinem gesamten Schul-Leben (Gymn.) NIE über eine erträgliche Drei in Mathe herauskam, ziemlich leicht versteht. Also, wo ist euer Problem? Bevor also einige Oberschlaue hier als dagegen wettern, seid doch einfach nicht zu stolz zuzugeben, dass ihr es nicht geblickt habt. Und lasst es euch nochmal erklären.  Ich lese übrigens selbst gerne noch mehr Erklärungen darüber, so LERNT man... MfG [Beitrag von lumi1 am 09. Nov 2012, 12:19 bearbeitet] |

||||||||||

|

Hörschnecke

Inventar |

#128

erstellt: 09. Nov 2012, 22:37

|

|||||||||

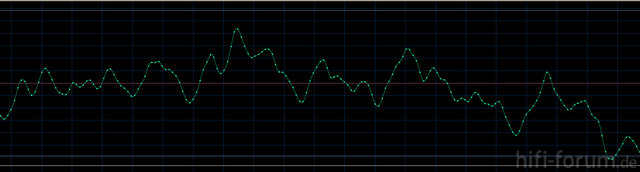

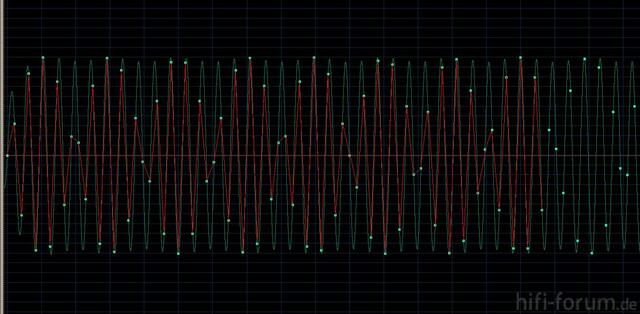

Das ist langweilig. Interessanter sind die Übergangsbereiche der Filterkurven. Dazu mal ein konkretes Beispiel in Wort und Bild: Original-Track oben ist ein schnöder Sinus von 21500 Hz, 3 Sekunden Dauer und 0.5 FullScale. Da er bei einer Samplingrate von 48000Hz/16bit generiert wurde, verletzt dieser Ton das Abtasttheorem nicht. Für den zweiten Track wurde dieser Ton auf 44100Hz/16bit downgesampelt. Auch hier verletzt der Testsinus von 21500 Hz die maximale Bandbreite von 22050 Hz nicht. Die Amplitude ist aber im Vergleich zum Original deutlich kleiner geworden ("leiser"). Grund ist das Interpolationsfilter, welches beim Downsampling wirkt und mit seiner real endlichen Steilheit auch schon Frequenzen unterhalb von 22050 Hz dämpft. Im dritten Track wird dieser dezimierte Sinus wieder zurück auf die originale Samplerate upgesampelt. Da auch hierbei erneut ein Interpolationsfilter benötigt wird (diesmal mit der Grenzfrequenz 24000 Hz), sinkt die Amplitude abermals. Vom ursprünglichen Sinus ist nach dieser Resampling-Prozedur nicht mehr viel übrig. Bild  |

||||||||||

|

cr

Inventar |

#129

erstellt: 09. Nov 2012, 22:49

|

|||||||||

|

Prinzipiell: Er verletzt aber Shannon. Der Sinus ist hinten und vorne abgeschnitten, ergo nicht bandbegrenzt und enthält Spektralanteile über 22000. In der Praxis wirds wohl eher am Filter gescheitert sein. [Beitrag von cr am 09. Nov 2012, 22:51 bearbeitet] |

||||||||||

|

Hörschnecke

Inventar |

#130

erstellt: 09. Nov 2012, 23:07

|

|||||||||

Wieso soll Deiner Meinung nach ein reiner Sinus von 21500 Hz bei einer Abtastrate von 44100 und 48000 Hz Shannon "verletzen"? Muß man jeden Ton Deiner Meinung nach unendlich lang machen, damit er Deinen Shannon nicht verletzt??

Dann erklär das mal, warum Interpolationsfilter in der Praxis scheitern. |

||||||||||

|

Jeck-G

Inventar |

#131

erstellt: 09. Nov 2012, 23:32

|

|||||||||

|

Also ich habe nur 0,15dB RMS Pegelverlust, wenn ich so wie Hörschnecke es beschrieben hat umherwandle (Cool Edit 2000 mit Standardeinstellung beim Resamplen). Auch zeigt (wie weiter oben beschrieben) Cool Edit die Sinuskurve nahezu richtig an (als ob ich ein Oszi anschließen würde), Audacitiy zeigt es hingegen völlig falsch an. |

||||||||||

|

cr

Inventar |

#132

erstellt: 09. Nov 2012, 23:35

|

|||||||||

Meine Meinung ist unmaßgeblich. Mathematisch gesehen ist es in der Tat so. Auch ist es nicht mein Shannon, sondern ein mathematischer Satz, der die Omega/2-Bandbegrenzheit fordert. Ist diese nicht erfüllt, gilt er nicht (in der Praxis treten Fehler auf, die umso größer werden, je mehr Spektralanteile jenseits Omega/2 sind) Warum Filter scheitern? Weil es keinen realisierbaren Filter gibt, der im kleinen Bereich von 21.500 bis 22.000 Hz eine Filterwirkung von 0 auf 100 dB erzielt, ohne andere Auffälligkeiten zu produzieren. Als nächstes kommst du mit 21.999 Hz und wunderst dich, dass es in der Praxis nicht funktioniert....

Dann verwendet Audacity wohl keinen sauberen Algorithmus, schätze ich mal [Beitrag von cr am 09. Nov 2012, 23:40 bearbeitet] |

||||||||||

|

cr

Inventar |

#133

erstellt: 09. Nov 2012, 23:37

|

|||||||||

|

Weit interessanter wäre, was mit 20 oder 19 kHz passiert......, um praxisrelevante Bereiche zu nehmen anstatt Ultraschall. Vielleicht klappts dann auch mit Audacity?! [Beitrag von cr am 09. Nov 2012, 23:41 bearbeitet] |

||||||||||

|

Jeck-G

Inventar |

#134

erstellt: 09. Nov 2012, 23:57

|

|||||||||

|

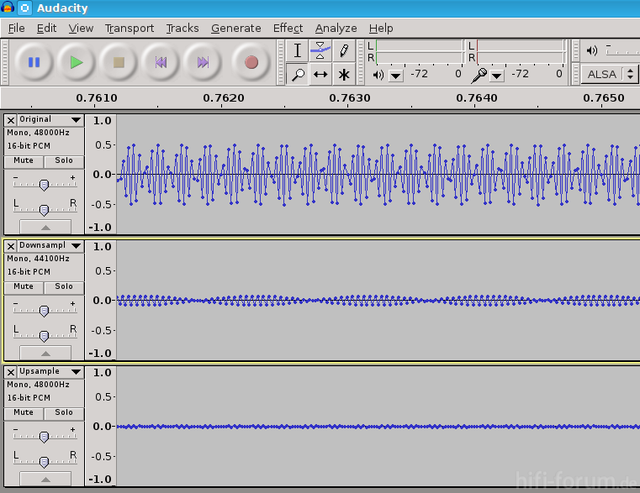

Zum Vergleich mal die Ansichten von Cool Edit (grün) und Audacity (rot, von Hand reingezeichnet nach Vorlage der hier zu sehenden Screenshots).  Es ist der 21,5 kHz-Sinus auf 16/48 in Originalform. Natürlich wieder Bild anklicken und Vollbild nehmen... [Beitrag von Jeck-G am 09. Nov 2012, 23:58 bearbeitet] |

||||||||||

|

Hörschnecke

Inventar |

#135

erstellt: 10. Nov 2012, 01:20

|

|||||||||

Audacity zeigt die Samples völlig korrekt an, wie Du nachträglich mit Deiner Montage selbst noch gezeigt hast (die Abtastwerte decken sich).

... natürlich ist Deine Meinung unmaßgeblich, ich finde es trotzdem bemerkenswert, daß Du Shannon verletzt siehst, wenn man einen Sinus von 21500 Hz mit 44100 Hz oder auch 48000 Hz sampelt.

... verdammte Realität aber auch!!

... verwendet wurde der Sample Rate Converter "Best Sinc Interpolator". Schätzt Du den als "keinen sauberen Algorithmus" ein? Der bereits gepostete  Link spricht von "... der Sinus cardinalis, ist dabei der ideale Interpolationskern für ganzzahlige Stützstellen ...". Link spricht von "... der Sinus cardinalis, ist dabei der ideale Interpolationskern für ganzzahlige Stützstellen ...".Welchen der möglichen, vorkommenden Interpolationfilter hast Du denn verwendet, Jeck-G? |

||||||||||

|

cr

Inventar |

#136

erstellt: 10. Nov 2012, 02:00

|

|||||||||

|

Dein Signal ist kein Sinus, sondern ein abgeschnittener Sinus und erfüllt Shannon nicht. Was soll ich noch dazu sagen! Beweise, dass dein Signal bandbegrenzt ist! Laien erkennen halt selten, dass durchs Abschneiden ein nach oben offenes Spektrum entsteht. Sicher ist es hier von der Intensität nur sehr schwach, weil 3 sek relativ lange ist im Vergleich zu einer Sinusschwingung von 21500 Hz. [Beitrag von cr am 10. Nov 2012, 02:07 bearbeitet] |

||||||||||

|

Burkie

Inventar |

#137

erstellt: 10. Nov 2012, 08:15

|

|||||||||

Wieso glaubst du, dass die Amplitude sinkt? Woraus schließt du das? Grüße [Beitrag von Burkie am 10. Nov 2012, 09:40 bearbeitet] |

||||||||||

|

Jeck-G

Inventar |

#138

erstellt: 10. Nov 2012, 09:21

|

|||||||||

Übrigens konnte ich nicht die Abtastwerte von Deinem Bild nehmen oder es zum Vergleich nehmen, da der Sinus in meinem Bild bei 0 anfängt (Anfang), bei Dir hingegen stammt es von irgendwo mitten drin. Also ist Deine Behauptung doppelt falsch... |

||||||||||

|

Hörschnecke

Inventar |

#139

erstellt: 10. Nov 2012, 10:10

|

|||||||||

... aus der Bestimmung des RMS der drei Sinus-Schwingungen: 1. Original -9,0 dBFS 2. Downsample -25,6 dBFS 3. Upsample -42,2 dBFS

... das, was ich Dich dazu gefragt hatte: Ob für Dich ein Sinus erst unendlich lang (dauernd) sein muß, damit Shannon nicht verletzt ist?

Nur die Samples zählen, mit der grafischen Interpolation auf einem Bildschirm kannst Du herumspielen, wie Du willst. Akustisch hörbar wird sowie so nur, was die realen, physikalischen Filter später aus den diskreten Samples machen. Natürlich sind verschiedene Ansichtmöglichkeiten eine wünschenswerte Option, aber am Ende haben wir nur die diskreten Samples.

... Dein Problem! Niemand kann etwas dafür, wenn Du Schwierigkeiten bei Deiner zeitlichen Synchronisation in einer grafischen Abbildung hast. Meine Samples liegen selbstverständlich auf einer Sinuskurve, wie Du sie abgebildet hattest  |

||||||||||

|

H_Schütte

Ist häufiger hier |

#140

erstellt: 10. Nov 2012, 10:37

|

|||||||||

|

Audacity zeigt es richtig an, Cooledit verwendet so etwas wie ein Oversamplingfilter, und zeig deswegen keine Pegeleinbrüche, aber zeigt sher wohl die Sampelpunkte. Da ich von 20 Jahren selbst an einem Digital Delay (für Dolby Surround) kann ich nur bestätigen, wie fürchterlich ein AD/DA gewandelter 20 kHz Sinunston des D/A Wandler bei 44,1 Khz Samplingrate verlässt (ohne Overampling, nur mit Tiefpassfilter der 4. Ordnung /24dB/okt. (betrachtet auf einem Oszilloscope) Erst wenn dies Filter derart lange Einschwingzeiten aufweist, mildert es diese Pegelschwankungen. Ein Oversamplingfilter entfernt diese Pegelschwankungen komplett, aber mit dem Nachteil, das zig Samples gleichzeitig für diese die Rechanarbeit in diesem Filter benötigt werden, und deswegen kommt es zu Vor- und Nachechos des eigentlichen Nutzimpuls. So ist halt die Physik, und jede Medaille hat zwei Seiten! [Beitrag von H_Schütte am 10. Nov 2012, 10:38 bearbeitet] |

||||||||||

|

Jeck-G

Inventar |

#141

erstellt: 10. Nov 2012, 10:48

|

|||||||||

Dann zeig uns mal Deine Sinuskurve. Meine RMS-Werte: 1. Original -9,01 dBFS 2. Downsample -9,01 dBFS 3. Upsample -9,16 dBFS Der Algorithmus beim Umwandeln ist nicht angegeben. Auch weiß CoolEdit (übrigens der Vorgänger von Adobe Audition) nicht nach der Bearbeitung, wie es vor der Bearbeitung war, denn es arbeitet aufgrund mangelnder Leistung damaliger Rechner (64 bis 128MB RAM, wenns hochkommt) direkt bzw. destruktiv (nur für die Undo-Funktion wird sich der letzte Stand gemerkt), moderne Programme können mehrere Filter miteinander verknüpfen. Zusätzlich wurde nach jedem Schritt eine neue Datei abgespeichert, geschlossen und neu geladen. |

||||||||||

|

H_Schütte

Ist häufiger hier |

#142

erstellt: 10. Nov 2012, 11:36

|

|||||||||

|

Der Cooledit arbeitet nach meinem Kenntnisstand mit der Fourier-Transformation.  Link zu Wikipedia Link zu WikipediaBei einem Resampling filtert der Cooledit etwas vor der teoretischen Maximalfrequenz (FSample/2) Dies erklärt auch die Pegelverluste des 21,5 kHz Signals. @cr Ein Sinus von 20Khz läst sich nunmal nicht richtig Abbilden bei einer Samplingrate von 44,1 Khz, da wärend der Einzelschwingung nur knapp mehr als 2 Samples erfasst werden. Selbst ein Rechteck sieht digitalieseirt verdammt ähnlich aus, zumal jeder A/D Wandler einen Bandpass vorgeschaltet haben sollte, der sicher verhindert, dass Frequenzen überhalb von FS/2 das Sample and Hold des Wandlers passieren. Geht natürlich besser, wen auch bei der A/D Wandlung mit Oversamling gearbeitet wird, und ein entsprechend dimensoniertes Diagitalfilter verwendet wird Wenn ein Rechteck durch einen Tiefpassfilter seinen Harmonischen beraubt wird, bleibt ein reiner Sinus in der Grundfrequenz übrig, und genau dass passiert bei einer ordentlichen A/D Wandlung. Hintergrund: wünde bei einer Samplingfrequenz von 44,1 kHz ein Nutzfrequenz von 25,1 kHz gesampelt werden, entsteht eine Spiegelfrequenz von 23,1 Khz nach der Wandlung. Das ist der Grund, warum eine Bandbreitenbegrenzug vor einem Donwnresample durchgeführt werden sollte. [Beitrag von H_Schütte am 10. Nov 2012, 11:45 bearbeitet] |

||||||||||

|

drSeehas

Inventar |

#143

erstellt: 10. Nov 2012, 11:39

|

|||||||||

Wieso? Wieviel Promille der HiFi-Hörer können tatsächlich noch 21500 Hz hören? Welche maximale Frequenz hörst du noch links/rechts? |

||||||||||

|

Jeck-G

Inventar |

#144

erstellt: 10. Nov 2012, 12:18

|

|||||||||

|

Und vor allem: Welche Musikinstrumente erzeugen in diesem Bereich (über 18kHz) noch verwertbare Töne? Künstliche Signalquellen (Frequenzgeneratoren, Synthesizer) und Hundepfeifen mal ausgenommen.

[Beitrag von Jeck-G am 10. Nov 2012, 12:21 bearbeitet] |

||||||||||

|

AndreasHelke

Stammgast |

#145

erstellt: 10. Nov 2012, 12:21

|

|||||||||

|

Bei Musik wird das keiner hören weil die Lautstärke viel zu niedrig ist. Selbst wenn das eigne Gehör so hohe Töne tatsächlich wahrnehmen kann funktioniert das nur bei Lautstärken die das Gehör bei dieser Frequenz nach kürzester Zeit irreparabel schädigen. Real existierendes Audio Equipment hat meistens sowieso einen Filter eingebaut der Frequenzen über 20 kHz entfernt. Das ist häufig auch dann aktiv wenn der DAC Digitalsignale mit 96 oder 192 kHz Samplefreqzuenz wiedergibt. |

||||||||||

|

Hörschnecke

Inventar |

#146

erstellt: 10. Nov 2012, 13:03

|

|||||||||

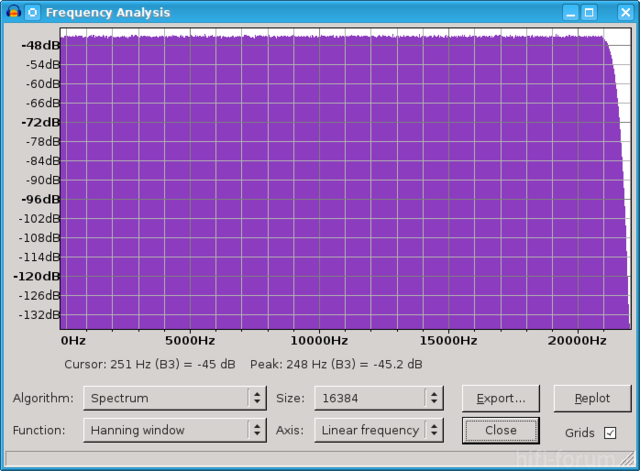

Das ist jetzt aber albern. Erkennst Du immer noch nicht, daß meine gezeigten Werte eine Sinuskurve abtasten? Hier also nochmal eine grobe Bildmontage als Extrawurst nur für Dich:  Bild1 Wie H_Schütte bereits gesagt hat, haben alle realen Interpolatoren zwei Seiten einer Medaille. Für den mathematisch idealen Sinus funktioniert z.B. der ZOH-Interpolator von Audacity ganz gut, zumindest wenn man nur das Einzelkriterium der Amplitudentreue heranzieht: RMS-Werte von Audacity wieder beim Resampling nach obigem Muster: 1. Original -9,0 dBFS 2. Downsample -9,0 dBFS 3. Upsample -9,0 dBFS  Bild2 Deshalb ist der ZOH-Interpolator aber nicht automatisch der beste Interpolator! Über das Verhalten bei realen, komplexen Musikaufnahmen und z.B. Impulstreue ist damit noch nicht alles ausgesagt. Die beispielhaften Informationsverluste im Amplitudenbereich beim Best Sinc Interpolator hatte ich ja bereits erläutert, aber zum besseren Verständnis kann vielleicht auch nochmal folgendes Bild dienen. Beim Downsampling in der beschriebenen Weise - nur daß diesmal weißes Rauschen mit der gesamten Bandbreite statt eines reinen Sinus verwendet wurde - sieht man den in der Praxis üblichen sanften Roll-Off bis zur Grenzfrequenz. Dieser wirkt sich auf hohe Frequenzen beim Resampling in der dokumentierten Weise aus.  Bild3 |

||||||||||

|

drSeehas

Inventar |

#147

erstellt: 10. Nov 2012, 13:12

|

|||||||||

|

anon123

Inventar |

#148

erstellt: 10. Nov 2012, 13:25

|

|||||||||

|

@Hörschnecke:

Beliebst Du zu scherzen? Der FQ ist von 0 bis über 20kHz linealgerade. Mit etwas Phantasie kann man dort eine Abweichung von +/- 0,5 dB erkennen. Und das zeigt "Informationsverluste"?  |

||||||||||

|

Jeck-G

Inventar |

#149

erstellt: 10. Nov 2012, 13:27

|

|||||||||

[Beitrag von Jeck-G am 10. Nov 2012, 13:29 bearbeitet] |

||||||||||

|

Hörschnecke

Inventar |

#150

erstellt: 10. Nov 2012, 13:41

|

|||||||||

|

@anon123, vielleicht ist Dir entgangen, daß das Original in den Beispielen entweder 21500 Hz Sinus oder weißes Rauschen bei 16/48 enthielt und deshalb beim Resampling auf 44.1 und wieder 48 jeweils Informationsverluste aufgetreten sind. Das steht in keinem Widerspruch zur Theorie.

Du siehst mit Deinem selektiven Blick eigentlich nur, daß die Amplitude bei 20 kHz kein Problem darstellt. Das ist trivial und langweilig. Im Thread ging es aber um die Vorgänge von Up- und Downsample-Prozeduren und welche Verluste da im Spiel sind bzw. um das nicht-ideale Verhalten. - Wie jeder für sich diese technischen Vorgänge in ihrer klanglichen Bedeutsamkeit wertet, ist hier nicht mein Thema. Für "Extremismus" sind andere zuständig  |

||||||||||

|

Joe_M.

Stammgast |

#151

erstellt: 10. Nov 2012, 14:20

|

|||||||||

|

Dumme Zwischenfrage: Wenn das Signal doch Mono, 44100 Hz, 16 Bit ist, dann kann man doch (zumindest theoretisch) bis 44100 Hz abbilden, oder nicht? Normalerweise wird doch ein Stereosignal codiert... Ich vermute, in der Praxis funktioniert das schon alleine wegen der Filter nicht. Wie sieht das denn in der Praxis aus? Gibt es überhaupt einen Unterschied zwischen Stereo und Mono? Doppelte so hohe Zeitauflösung möglicherweise? Grüße Joe |

||||||||||

|

AndreasHelke

Stammgast |

#152

erstellt: 10. Nov 2012, 15:00

|

|||||||||

|

Man braucht mindestens 2 Samples pro Sinuswelle um das Analogsignal korrekt wieder herstellen zu können. Mehr Samples nützen nichts, aber wenn man weniger verwendet wird das Analogsignal völlig ruiniert wenn hohe Frequenzen im Digitalsignal vorhanden sind. Das ist die schöne Theorie. In der Praxis braucht man ein Filter dass dafür sorgt dass die zu hohen Frequenzen entfernt werden. Durch die Nebenwirkungen dieser Filter gibt es Veränderungen für Frequenzen die in der Nähe des absoluten Maximums liegen. Wenn man ein gutes Filter verwendet reichen 44.1 kHz Samplefrequenz um 20 kHz ohne hörbare Änderungen wiederzugeben. Ich halte es für möglich dass die ersten DA Wandler und Filtern mit diesen Frequenzen noch Probleme hatten. [Beitrag von AndreasHelke am 10. Nov 2012, 15:00 bearbeitet] |

||||||||||

|

drSeehas

Inventar |

#153

erstellt: 10. Nov 2012, 15:03

|

|||||||||

Ja, das ist eine dumme Frage: Was willst du mit einem Signal (Ultraschall), das kein Mensch mehr hören kann? Die Abtastfrequenz ist bei der CD 44100 Hz, die Nyquist-Grenze (= maximale Signalfrequenz) liegt bei der Hälfte (22050 Hz) dieser Abtastfrequenz. Du hast wohl Abtastfrequenz mit maximaler Signalfrequenz verwechselt? [Beitrag von drSeehas am 10. Nov 2012, 15:09 bearbeitet] |

||||||||||

| ||||||||||

|

|

||||

| Das könnte Dich auch interessieren: |

|

Wandlerunterschied Burr-Brown 24-Bit/96 kHz vs. Burr-Brown 192 khz/24-bit Milamedia am 22.02.2009 – Letzte Antwort am 30.03.2009 – 41 Beiträge |

|

NAIM UnitiServe 192 kHz abspielen ? onkel-thor am 04.01.2022 – Letzte Antwort am 14.01.2022 – 3 Beiträge |

|

Electrocompaniet PD1 neuer DAC 192 khz/24bit Puredirect am 09.01.2011 – Letzte Antwort am 12.01.2011 – 8 Beiträge |

|

Sampling Conversion 44,1 auf 48 kHz Qualitätsverlust? dharkkum am 19.09.2011 – Letzte Antwort am 18.10.2011 – 9 Beiträge |

|

DVD-Player als CDP ersatz??? Class_B am 12.05.2006 – Letzte Antwort am 30.05.2006 – 48 Beiträge |

|

Update EMC-1 von Electrocompaniet Joerg000 am 13.06.2006 – Letzte Antwort am 01.08.2008 – 6 Beiträge |

|

Technics DAT SV-DA10, analog aufnehmen mit 44,1 kHz ? Masselcat am 23.07.2010 – Letzte Antwort am 30.07.2010 – 6 Beiträge |

|

Marantz SA15S2 pruedi0 am 26.01.2015 – Letzte Antwort am 26.01.2015 – 2 Beiträge |

|

Ab wann machen SACDs Sinn? d33k4y am 24.10.2011 – Letzte Antwort am 24.11.2011 – 65 Beiträge |

|

MP3 Upsampling 24/192 sni_hh am 16.06.2010 – Letzte Antwort am 11.07.2010 – 22 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in CD-/SACD-Player & andere digitale Quellen der letzten 7 Tage

- Wie viel Sinn machen 32 Bit, 192 kHz und 384 kHz?

- Musik CD abspielen mit BluRay Player

- Laufwerksgeräusche von CD-Playern

- Klangverlust durch XLR auf Cinch?

- Bluesound Node + ext Netzteil Teddy Pardo

- Was tun , wenn CD nicht erkannt wird?

- CD-Wiedergabe - knistern etc

- Panasonic SC-PM02 erkennt USB-Stick nicht

- Wann wird Jitter hörbar? Und kann man Digitalgeräte mit hörbarem Jitter tatsächlich kaufen?

- Marantz SA 11 S3 oder Ruby KI

Top 10 Threads in CD-/SACD-Player & andere digitale Quellen der letzten 50 Tage

- Wie viel Sinn machen 32 Bit, 192 kHz und 384 kHz?

- Musik CD abspielen mit BluRay Player

- Laufwerksgeräusche von CD-Playern

- Klangverlust durch XLR auf Cinch?

- Bluesound Node + ext Netzteil Teddy Pardo

- Was tun , wenn CD nicht erkannt wird?

- CD-Wiedergabe - knistern etc

- Panasonic SC-PM02 erkennt USB-Stick nicht

- Wann wird Jitter hörbar? Und kann man Digitalgeräte mit hörbarem Jitter tatsächlich kaufen?

- Marantz SA 11 S3 oder Ruby KI

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder930.496 ( Heute: 1 )

- Neuestes MitgliedRaccoon59

- Gesamtzahl an Themen1.562.987

- Gesamtzahl an Beiträgen21.814.026