| HIFI-FORUM » Fernseher & Beamer » LCD-Fernseher » Sony » Sony ZD9 Serie 65"/75"/100" mit Bac... | |

Gehe zu Seite: |vorherige| Erste .. 50 . 60 . 70 . 80 . 88 89 90 91 92 93 94 95 96 97 . 100 . 110 . 120 . 130 .. Letzte |nächste|

|

|

||||

Sony ZD9 Serie 65"/75"/100" mit Backlight Master Drive+A -A |

|||||||

| Autor |

| ||||||

|

Taunussteiner

Stammgast |

#4704

erstellt: 25. Feb 2017, 17:21

|

||||||

|

Vielen lieben Dank  Ich bin so happy Ich bin so happy  EDIT: Unnötiges Direkt-Komplettzitat durch die Moderation entfernt! [Beitrag von OSwiss am 26. Feb 2017, 19:10 bearbeitet] |

|||||||

|

kamio

Ist häufiger hier |

#4705

erstellt: 25. Feb 2017, 17:58

|

||||||

|

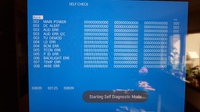

Hallo, eine Frage zum Service Menü. Ich habe es heute eingeschaltet und kam erst wieder heraus als ich einen Neustart gemacht habe. Wie schaltet man es richtig aus ? Mit Home, Back oder Exit ging es nicht. Auch mit der Reihenfolge wie beim Einschalten nicht. Meine Stundenlaufzeit kommt hin, nur was bedeutet die Zahl in der Mitte ?  Zum ZD 9 : Ist bei mir ohne Fehler und hat ein super Bild. Ich hätte mir nur gewünscht daß er PIP und Timeshift hätte. Auch mehr Apps zum installieren zB Google Earth oder Stellarium wäre auf so einem großen TV super. Gruß kamio |

|||||||

|

|

|||||||

|

orionics

Inventar |

#4706

erstellt: 25. Feb 2017, 18:51

|

||||||

|

@ kamio Erste Zahl = Panel operation time by hour Zweite Zahl = Boot count Dritte Zahl = Total operation time by hour Gruß orionics |

|||||||

|

macfly75

Hat sich gelöscht |

#4707

erstellt: 25. Feb 2017, 18:56

|

||||||

Da wird beide ja aus dem Samsung Lager kommen und ich auch vor allem mit der Bewegtbilddarstellung völlig unzufrieden bin, freut mich dein positives Feedback natürlich besonders  Jetzt hoffe ich nur, dass ich demnächst eine Versandbenachrichtigung bekomme. |

|||||||

|

Ralf65

Inventar |

#4708

erstellt: 25. Feb 2017, 19:01

|

||||||

|

So ganz nebenbei, komme ja auch aus dem Samsung Lager  Bin Dank der FALD Technik zu Sony gekommen und wegen der Bewegtbildwiedergabe Finde, alles richtig gemacht  [Beitrag von Ralf65 am 25. Feb 2017, 19:05 bearbeitet] |

|||||||

|

Danizo

Inventar |

#4709

erstellt: 25. Feb 2017, 19:05

|

||||||

|

Whaaaaat....ein Samseman im Sonythread... "IN DEN STAUB MIT DIR!!!"   |

|||||||

|

kamio

Ist häufiger hier |

#4710

erstellt: 25. Feb 2017, 19:09

|

||||||

|

Hallo orionics, danke für die schnelle Info. Gruß kamio |

|||||||

|

Savini6437

Stammgast |

#4711

erstellt: 25. Feb 2017, 19:33

|

||||||

|

Ich bin noch im Samsung Lager, will aber zum ZD9 wechseln, überlege ob ich den 65 Zoll oder 75 Zoll nehme, sitze knapp 4 m weg vom Fernseher. Sind die 65 Zoll besonders von DSE und Banding betroffen? |

|||||||

|

Ralf65

Inventar |

#4712

erstellt: 25. Feb 2017, 20:09

|

||||||

|

Sitze knapp 4,5m Weg und da war mir ein 65" zu klein, gäbe es den ZD9 in 85", wäre das (mal vom Preis abgesehen) meine Wahl geworden, also lieber zu 75" hin orientieren |

|||||||

|

jruhe

Inventar |

#4713

erstellt: 25. Feb 2017, 20:29

|

||||||

|

Ich sitze 2,50 m weg vom 65". Abgesehen vom ästhetischen Problem, dass ich mit der Größe des Geräts im Verhältnis zu meinem Wohnzimmer habe, empfinde ich den Abstand als ideal. Um 4K von Full HD unterscheiden zu können, muss man ja recht nahe am TV sitzen. @Ralf65 Gib es einen Weg, der XBox One S beizubiegen, nur Blu Rays mit 1080p24 auszugeben? jruhe [Beitrag von jruhe am 25. Feb 2017, 20:29 bearbeitet] |

|||||||

|

hmt

Inventar |

#4714

erstellt: 25. Feb 2017, 20:31

|

||||||

http://www.pcgamesha...-verfuegbar-1221792/ http://www.pcgamesha...-verfuegbar-1221792/Zum Thema DV, da hier einige nicht glauben wollen, dass dies per Software zu realisieren ist. QED. |

|||||||

|

Mikelheikel

Stammgast |

#4715

erstellt: 25. Feb 2017, 20:33

|

||||||

|

Ich sitze 3,5 Meter weg von meinem 75" Full HD. Es sind keine Pixel oder sonstiges zu erkennen. Bei UHD wirds noch besser. Also 75" wählen  |

|||||||

|

Savini6437

Stammgast |

#4716

erstellt: 25. Feb 2017, 20:39

|

||||||

|

Danke für eure Empfehlungen, dann warte ich mal ab ob es Angebote für den 75 Zoll gibt, auf der Sony Homepage gibt es ja keine Preise |

|||||||

|

govindam

Ist häufiger hier |

#4717

erstellt: 25. Feb 2017, 20:50

|

||||||

|

Bei 4m würde ich definitiv zu 75" greifen. Ich sitze 3m weg. Da sind 65" optimal. Beim 75" ZD9 scheint es auch bessere Qualitätskontrollen zu geben. |

|||||||

|

tovaxxx

Inventar |

#4718

erstellt: 25. Feb 2017, 22:37

|

||||||

|

Hab eben "Don't Breathe" auf dem ZD9 geschaut. Die Balken waren grau!  Ich denke aber, dass es vom Film kommt und miserabel gemastert wurde. Hat jemand die Scheibe und kann das bestätigen? Ansonsten sind die Balken immer schön schwarz. |

|||||||

|

Sephi66

Inventar |

#4719

erstellt: 26. Feb 2017, 00:27

|

||||||

|

Kann ich nicht bestätigen hatte den heute gerade zur Hand weil ich den letztens erst gesehen hatte, sehr spannend mal nebenbei  Also grau ist da nix in den Balken mein HX925 dimmt das eben so gut wie es auf dem TV der 7 Jahre alt ist möglich ist  Wenn zu den Kinobalken mal ein heller Hintergrund ist leuchtet es halt minimal ein ansonsten alles schwarz wenn auch nicht TV Rahmen schwarz und das Bild ist sehr gut hab schon schlechtere Bildquali gesehen. Wenn zu den Kinobalken mal ein heller Hintergrund ist leuchtet es halt minimal ein ansonsten alles schwarz wenn auch nicht TV Rahmen schwarz und das Bild ist sehr gut hab schon schlechtere Bildquali gesehen. |

|||||||

|

3DSE

Stammgast |

#4720

erstellt: 26. Feb 2017, 01:40

|

||||||

|

Schwachsinn, da ist überhaupt nichts grau. Vorgestern gesehen. |

|||||||

|

Ralf65

Inventar |

#4721

erstellt: 26. Feb 2017, 05:46

|

||||||

|

[quote="j @Ralf65 Gib es einen Weg, der XBox One S beizubiegen, nur Blu Rays mit 1080p24 auszugeben? jruhe[/quote] das kann ich Dir ehrlich gesagt gar nicht beantworten, für Blu-rays habe ich die XBox noch gar nicht genutzt, die werden weiterhin über den BDP-LX88 wieder gegeben.... |

|||||||

|

Ralf65

Inventar |

#4722

erstellt: 26. Feb 2017, 06:05

|

||||||

es ist immer eine Frage wie man diese Aussage liest oder versteht, denn im Grunde ist dies nichts neues und seit letztem Jahr so auch bekannt. Eine Software muss man irgendwo hineinschreiben und zwar dahin, wo sie ihren Anwendungszweck erfüllen kann, dementsprechend braucht diese dort auch freien Speicherplatz und der Hinweis "Vorausgesetzt die Geräte verfügen über ausreichend Rechenleistung" sagt dann eigentlich schon fast alles aus, denn mal eben nachrüsten in ein autarkes System ist nur möglich, wenn die Grundvorraussetzung (in Form von Prozessorleistung und Speicherplatz) dafür im Vorraus bereits von den Herstellern geschaffen wurden (Sony, Oppo, LG, Vizio ), bei einer Spielkonsole würde dies daher sicherlich auch kein Problem darstellen. Bei einfachen Geräten, die mit geringen Arbeitsspeicher und auf die aktuellen Bedürfnisse ausgelegten Prozessoren arbeiten wird dies daher weiterhin auch nicht möglich sein, geschweige denn auf Grund der dafür nötigen Lizensierung kostenmäßig sinnvoll. Bleibt also abzuwarten, welche "bereits existierenden Geräte" die nötigen Vorraussetzungen dazu erfüllen und welche Hersteller die Möglichkeit dann auch tatsächlich so nutzen und umsetzen werden..... Das "es dazu lediglich ein HDMI 1.4-Port zur Übertragung" benötigt, wurde von vorne herein so in den Specs von DolbyVision geäußert, lediglich die letzten Diskusionen seitens Philips und deren Thema "dynamisches HDR" haben ein dafür nötiges HDMI2.1 ins Spiel gebracht [Beitrag von Ralf65 am 26. Feb 2017, 07:55 bearbeitet] |

|||||||

|

tovaxxx

Inventar |

#4723

erstellt: 26. Feb 2017, 07:38

|

||||||

Du solltest Deinen Ton überdenken.  Dann hab ich hier irgendeine falsche Einstellung beim Q5. Muss ich mal heute Abend testen.  |

|||||||

|

hagge

Inventar |

#4724

erstellt: 26. Feb 2017, 09:41

|

||||||

Vorsicht. Auf dem ZD9 wird der Vorteil von Dolby Vision erstaunlich gering ausfallen. Hier mal kurz warum. Viele Leute verstehen nämlich gar nicht, warum Dolby Vision momentan bei manchen Fernsehern so viel bringt. Ein HDR-Film gibt in seinen Metadaten an, wie dunkel die dunkelste Stelle und wie hell die hellste Stelle ist. Bei statischen Metadaten wie bei HDR10 gelten diese Daten für den gesamten Film, bei dynamischen Metadaten wie bei Dolby Vision können es auch kleinere Einheiten sein, z.B. einzelne Szenen. Nehmen wir mal an, ein Film ist für 1000 cd/m² maximale Helligkeit gemastered. Das sind die meisten HDR10-Filme momentan. Das heißt der Film sagt zu Beginn: "Im Film kommen minimal 0,01 cd/m² und maximal 1000 cd/m² vor." Was sagt ein ZD9 dazu? "Gut, mache ich". Kann er gut, denn er kann diesen Kontrastbereich vollumfänglich darstellen. Das heißt er kann von vorne bis hinten im Film immer die im Film geforderten Helligkeiten 1:1 an sein Panel weitergeben. Was macht aber ein TV, der z.B. maximal 700 cd/m² kann? Beispielsweise ein OLED? Nun, er muss ja damit rechnen, dass jederzeit mal 1000 cd/m² vorkommen können. Damit er oben also noch etwas Reserve hat, muss er den gesamten Film etwas dunkler wiedergeben. So dass die Stellen, die dann 1000 cd/m² fordern, bei ihm mit seiner maximalen Helligkeit 700 cd/m² angezeigt werden können. Also wird der gesamte Film etwas zu duster erscheinen. Alternativ könnte der OLED dann auch sagen, OK, ich fahre trotzdem mit den nominellen Helligkeiten, wie sie der Film fordert. Aber dann kann er bei den Stellen, die 1000 cd/m² abfordern, eben nichts mehr drauflegen. Diese Stellen haben dann White Crush. Oder er macht eine Kombination, d.h. er zeigt dunkler an, aber nur ein klein wenig dunkler, und hat dann trotzdem noch leichten White Crush in den ganz hellen Stellen. Oder er senkt den gesamten Helligkeitsbereich nicht-linear ab. Lässt also die dunklen Stellen im Bild eher unverändert und senkt die höheren Helligkeiten stärker ab. Staucht also den Kontrast zusammen. Wie auch immer, es ist immer ein Kompromiss und es sieht nicht perfekt aus. Dieses Umrechnen der geforderten Helligkeiten auf konkrete verwendete Helligkeiten wird als Tonemapping bezeichnet. Je nachdem wie gut dieses Tonemapping ist, sieht das Ergebnis mehr oder weniger gut aus. Was passiert aber nun, wenn dynamische Metadaten ins Spiel kommen? Dann kann der TV individuell für jede Szene entscheiden, was zu tun ist. Wenn der OLED also nun eine Szene angekündigt bekommt, die nur bis 700 cd/m² oder weniger geht, dann kann er 1:1 umsetzen. Nur in den Szenen, wo mehr als 700 cd/m² gefordert sind, da muss er wieder den Kompromiss von oben eingehen. Die dynamischen Metadaten bewirken also, dass TVs, die die maximal geforderte Helligkeit nicht liefern können, nicht den gesamten Film über mit einem Kompromiss arbeiten müssen, sondern nur in relativ wenigen Szenen, wo diese hohen Helligkeiten tatsächlich gefordert werden. Das heißt über große Strecken des Films können sie auch voll aufdrehen und der Film erscheint "korrekt". Ein TV, der aber von vorne herein die volle geforderte Helligkeit kann, dem reicht auch die Angabe für den ganzen Film. Klar, er könnte theoretisch in den Szenen, wo weniger Helligkeit gefordert wird, ein bisschen mehr aufdrehen, aber das ist dann schon mehr, als eigentlich notwendig ist und wird in der Regel dann schon übertrieben wirken. Er sollte das also tunlichst bleiben lassen. So ein TV profitiert also überhaupt nicht von den dynamischen Metadaten. Es hängt also gar nicht so sehr an den dynamischen Metadaten, ob ein HDR-Film gut aussieht, sondern daran, ob der TV die geforderten Helligkeiten kann. Kann er die Helligkeiten, sind die dynamischen Metadaten egal. Kann er sie nicht, dann profitiert er von dynamischen Metadaten. Wenn also mal ein Film kommt, der Maximalwerte von über 1800 cd/m² fordert, dann kommt der ZD9 ebenfalls in dieses Dilemma und muss mit nicht optimalen Einstellungen fahren. *Dann* profitiert auch er von dynamischen Metadaten. Bei den momentanen HDR-Filmen, die mit 1000 cd/m² Spitzenhelligkeit gemastered sind, wird Dolby Vision mit seinen dynamischen Metadaten erstaunlich wenig Vorteile beim ZD9 bringen. Gruß, Hagge [Beitrag von hagge am 26. Feb 2017, 09:42 bearbeitet] |

|||||||

|

jruhe

Inventar |

#4725

erstellt: 26. Feb 2017, 10:08

|

||||||

Kleiner, aber gewichtiger Denkfehler. Für die wenigen, maximal hellen Effekte müssen bei HDR10 einige der 12 bit für den ganzen Film "reserviert" werden, d.h. sie sind für den Großteil der Zeit verschwendet, womit der Dynamikumfang des Films im Mittel reduziert wird. Bei Dolby Vision hingegen werden die zu Verfügung stehenden 12 bit hingegen maximal ausgenutzt, da sie pro pro Szene dynamisch verteilt werden. Der einzige Grund, dass der Unterschied nicht so krass ausfallen wird, ist, dass laut SONY der Prozessor schon jetzt eine dynamische Bildanalyse für HDR durchführt. jruhe [Beitrag von jruhe am 26. Feb 2017, 10:10 bearbeitet] |

|||||||

|

hmt

Inventar |

#4726

erstellt: 26. Feb 2017, 10:18

|

||||||

Und habe ich damals etwas anderes gesagt? Nein, ich schrieb deutlich, dass nur die HW leistungsfähig genug sein muss, was damals ein paar Kandidaten hier mal wieder nicht glauben wollten. |

|||||||

|

jruhe

Inventar |

#4727

erstellt: 26. Feb 2017, 10:20

|

||||||

Also, die verbauten Arm-CPU-Kerne haben mit der Bildverarbeitung normalerweise nichts zu tun. Sie sind für das Betriebssystem reserviert und maximal hier und da für das Dekoding von Videos in Apps zuständig. Ich denke, aber das ist nur eine Vermutung, dass nur Home Entertainment Geräte mit programmierbaren FPGAs in den Genuss der Nachrüstung kommen oder eben Konsolen, die tatsächlich für solche Dinge mehr als genug Rechenleistung mitbringen. Was ich mich allerdings frage ist, wie ein Player mit Dolby Vision umgehen soll. Die Metadaten sind doch ein Teil dekodierten des Videostroms. So bleibt ja eigentlich für den Player nur, den Container mit DV Content zu erkennen, den Inhalt richtig zu dekodieren und über HDMI weiterzuleiten. Wäre natürlich genial, wenn in diesem Zuge auch ein Fire TV UHD das Upgrade erfahren würde. jruhe [Beitrag von jruhe am 26. Feb 2017, 10:28 bearbeitet] |

|||||||

|

jruhe

Inventar |

#4728

erstellt: 26. Feb 2017, 10:26

|

||||||

Nein das hast Du nicht gesagt. Willst Du schon wieder damit anfangen? Ich bzw. wir haben gesagt: a) Dolby muss Willens sein, eine solche Lösung zu lizenzieren. Das sind sie offensichtlich nun b) die Geräte müssen entsprechend programmierbare Hardware haben. Und nein, das sind nicht die allgemeinen Arm-SoCs in den Geräten. Darüber läuft DV garantiert NICHT. Außerdem muss man bei DV zwischen Player (Aufbereitung für HDMI) und TV (Darstellung) unterscheiden. jruhe [Beitrag von jruhe am 26. Feb 2017, 10:27 bearbeitet] |

|||||||

|

hmt

Inventar |

#4731

erstellt: 26. Feb 2017, 10:41

|

||||||

|

Im ZD9 sitzt ein Mediatek MT5596. Das ist eine ARM CPU. Und natürlich läuft die Bildbearbeitung auf ARM. Dein Denkfehler ist es, zu glauben, dass dies Hexenwerk ist und extrem viel Rechenleistung benötigt. Das ist nach heutigen Maßstäben nicht mehr so. Da muss man sich einfach mal anschauen wie lahm auf dem ZD9 Android läuft bzw der Browser im Vgl mit einem Mittelklassehandy. irgendwleche 3D-Spiele brauchen deutlich mehr Leistung das das bisschen Motionflow und co. So fix ist der MT5596 des ZD9 nicht. [Beitrag von hmt am 26. Feb 2017, 10:44 bearbeitet] |

|||||||

|

Ralf65

Inventar |

#4736

erstellt: 26. Feb 2017, 10:55

|

||||||

|

Hallo     |

|||||||

|

hagge

Inventar |

#4737

erstellt: 26. Feb 2017, 10:55

|

||||||

Jein. Für das OS wird aber nur die CPU genutzt. Um was es hier aber geht sind andere Peripherieeinheiten neben der CPU. Natürlich kann theoretisch ein H.264- oder H.265-Video auch auf der CPU eines ARM-Cores in Software dekodiert werden, es wird aber nicht schnell genug funktionieren. Aber wenn ein solcher SoC einen Hardware-Decoder für H.264 bzw. H.265 enthält, dann geht das eben ruckelfrei und schnell genug. Das heißt nur weil etwas theoretisch in Software funktioniert, heißt das nicht, dass es auch in Software praktisch funktioniert.

Klar, wenn der SoC Dolby Vision unterstützt, dann kann es prinzipiell jeder TV, der diesen SoC einsetzt. Aber nicht jeder SoC wird eben für Dolby Vision vorbereitet sein und die anderen können es entsprechend *nicht*.

Auch das ist anders zu verstehen. Ab 7.0 unterstützt die Software grundsätzlich Dolby Vision, aber nur wenn die Hardware es unterstützt. Es wird also nicht automatisch aus einem Gerät ohne DV mit Android 7 auf einmal eines mit DV. Gruß, Hagge |

|||||||

|

Quickiman

Stammgast |

#4738

erstellt: 26. Feb 2017, 10:56

|

||||||

|

ganz wichtiges gequatsche von euch beiden.... was bringt den kunden ARM cpu, DV , HDR etc wenn so gefühlt 75% der ZD9 DSE haben? das ist so als wenn ich einen 400k€ Bentley auf eckigen Rädern ausliefere... das bringt nichts! und so lange die hersteller nichtmal das in den griff kriegen, scheiße ich ganz geschmeidig auf deren premium features... mein 250€ amazon deal des tages, toshiba 42" hat kein DSE. und der 20x teurere ZD9 sieht aus wie ein billig china produkt... SONY ist einfach nur lächerlich! |

|||||||

|

jruhe

Inventar |

#4739

erstellt: 26. Feb 2017, 10:57

|

||||||

|

Wenn Du das sagst.  jruhe |

|||||||

|

hmt

Inventar |

#4740

erstellt: 26. Feb 2017, 11:01

|

||||||

Es ist aber davon auszugehen, dass jedes halbwegs moderne Gerät einen SoC besitzt, der leistungsfähig genug ist. Die Klimmzug ist nicht so groß wie einige denken, Der SoC des ZD9 ist auch (wie ganz im allgemeinen in TVs verbaute SoCs) nicht besonders schnell. Viele SmartTVs der letzten beiden Jahre werden theoretisch für DV infrage kommen. Evtl. gibt es ja von Dolby bald eine Liste an SoCs, die leistungsfähig genug sind. Meine Vermutung ist, dass halbwegs aktuelle Mediatek SoCs darunter fallen (und die sind in vielen TVs verbaut). Insbesondere AndroidTV dürfte da ein Vorteil sein. BTW, für die meisten Videooperationen wird in den SoCs die GPU genutzt (ist bei dem Mediatek ein MaliTP). GPUs eignen sich sehr gut für diese Aufgaben. Es braucht keine dedizierte HW, die ist nur EIN weg DV zu realisieren. Es geht eben auch per Software. Nichts anderes als das sagt auch mein bereits geposteter Link. DV ist nur eine Software, die in irgendeiner Form laufen muss (ob nun dedizierter Einheit, CPU oder per GPU). [Beitrag von hmt am 26. Feb 2017, 11:05 bearbeitet] |

|||||||

|

Ralf65

Inventar |

#4741

erstellt: 26. Feb 2017, 11:03

|

||||||

genau wie Dein Kommentar dazu |

|||||||

|

Quickiman

Stammgast |

#4742

erstellt: 26. Feb 2017, 11:07

|

||||||

|

ich hab seit september zwei sony gehabt, XD93 und ZD9. dazu habe ich mir 4 ZD9 in läden angeschaut. JEDER dieser fernseher hatte bzw hat DSE. was soll da einem noch als kunde einfallen? |

|||||||

|

hmt

Inventar |

#4743

erstellt: 26. Feb 2017, 11:09

|

||||||

|

Ging mir leider auch so. Das ist aber hier schon oft angesprochen worden, einige Besitzer und hier postende Händler/Sony-Gesponsorte reagieren auf Kritik am Gerät aber eher allergisch.  |

|||||||

|

Ralf65

Inventar |

#4744

erstellt: 26. Feb 2017, 11:10

|

||||||

dabei steht immer noch die Aussage von der CES im Raum, das der verbaute Soc (X1 Extreme) des ZD9 Vorraussetzung für DV Update ist, die Socs der frühen 2016er TV Geräte (XD93 / XD94) sollen demnach nämlich nicht für das Upgrade geeignet sein, hier wurde nur das HLG Update in Aussicht gestellt. Also doch keine geeignete (leistungsfähige) Hardware in modernen TVs, oder reine Marketing Strategie, wer mag dies "mit Sicherheit" beurteilen können. [Beitrag von Ralf65 am 26. Feb 2017, 11:12 bearbeitet] |

|||||||

|

Quickiman

Stammgast |

#4745

erstellt: 26. Feb 2017, 11:12

|

||||||

|

ja merke ich, als wenn ich hier gotteslästerung am heligen gral betreiben würde. aber genau das muss man doch ansetzen. solange die qualität so bleibt, werden die ganzen features ad-absurdum geführt. |

|||||||

|

jruhe

Inventar |

#4746

erstellt: 26. Feb 2017, 11:14

|

||||||

Ok,danke. Ich habe es mittlerweile herausgefunden. Es geht tatsächlich nicht, wenn die Konsole auf 4K-Ausgabe fixiert oder auf 1080p mit "4K erlauben" gestellt ist. 1080p24 geht wirklich nur dann raus, wenn die Konsole auf 1080p-Ausgabe beschränkt wird, was nun nicht Sinn der Sache an einem 4K-TV sein kann. Das Upscaling der Xbox ist jedoch hervorragend. Vielleicht werde ich es trotzdem nochmal mit dem des ZD9 vergleichen, wenn ich mal Zeit habe. jruhe |

|||||||

|

jruhe

Inventar |

#4747

erstellt: 26. Feb 2017, 11:21

|

||||||

Das Problem streitet ja keiner ab. Hier geht es aber um subjektive Relevanz. Es ist halt abzuwägen, ob es für einen persönlich zu problematisch ist hinsichtlich der Tatsache, dass es zum ZD9 aktuell keine Alternative gibt. Ich muss sagen, dass ich jetzt schon durch HDR versaut bin und kann mir nicht vorstellen, ob OLEDs oder Edge-LEDs von SONY hinsichtlich ihrer Leuchtkraft dasselbe Erlebnis bieten können. Man muss es einfach in einem dunklen Raum gesehen haben. Wegen der überlegenen Bildverarbeitung bin ich außerdem an SONY gebunden. jruhe [Beitrag von jruhe am 26. Feb 2017, 11:25 bearbeitet] |

|||||||

|

hagge

Inventar |

#4748

erstellt: 26. Feb 2017, 12:04

|

||||||

Nein, wieso sollte das der Fall sein? Von den SoCs gibt es üblicherweise jede Menge Untervarianten, die sich genau in den verfügbaren Peripheriegeräten unterscheiden. Ich kenne das jetzt nicht speziell bei Mediatek, aber bei NXP-Embedded-SoCs kenne ich mich recht gut aus. Wenn man da einfach nur i.MX6 sagt, dann sagt das noch gar nichts aus. i.MX6Q und i.MX6D: Leistungsfähige 3D-GPU, 2 Bildeinheiten (IPU) zum Anschließen von bis zu vier Bildschirmen, VPU zum decodieren von Videos i.MX6DL und i.MX6S: Weniger leistungsfähige 3D-GPU, nur eine IPU, also max. zwei Displays, dafür Ansteuereinheit für E-Ink-Displays, gleiche VPU i.MX6SX: gar keine IPU, sondern eine ganze andere Bildeinheit (PXP), keine VPU für Videos, dafür einen eigenen asymmetrischen CPU-Core für Realtime-Anwendungen i.MX6UL: Bildeinheit wie i.MX6SX, aber keine 3D-Einheit, ebenfalls keine VPU, kein extra Core. Wenn man also ein E-Ink-Display anschließen will, nützt einem die leistungsstärkste Variante gar nichts, weil die das nicht drin hat. Will man Videos decodieren, nützt einem die GPU beim i.MX6SX nichts, weil die VPU fehlt. Und so ist das bei den Mediatek-CPUs ziemlich sicher auch.

Was ja auch schon zeigt, dass nicht die CPU für die ganze Bildverarbeitung zuständig ist, sondern dedizierte Hardware-Einheiten. Im TV würde ich sogar davon ausgehen, dass der Mediatek *gar* nicht für Dolby Vision zuständig ist, sondern der Bildprozessor X1 Extreme. Das deckt sich mit den Meldungen, dass nur die Sony-TVs mit X1-Extreme für Dolby Vision in Frage kommen.

Definitiv nein.

Nein, Die GPU wird für 3D-Operationen genutzt, nicht für Video. Dafür gibt es in den SoCs nochmal ganz eigene Einheiten. Siehe oben die VPU (Video Processing Unit) im i.MX6.

Eigentlich nicht. Auch bei den Desktop-GPUs war Videodecodierung nicht mit der GPU möglich, bis die Hersteller die entsprechenden dedizierten Videodecoder eingebaut haben. Bei AMD heißen die UVD (Unified Video Decoder), bei Intel heißt die Technik Quick Sync und bei Nvidia PureVideo HD. Aber das sind eigene Einheiten und nicht die GPU-Shader, die da arbeiten.

Theoretisch mag das sein. Praktisch sind weder die CPU-Cores noch die GPU-Cores eines solchen SoC in der Lage, die notwendige Bildverarbeitung ausreichend schnell in Software zu machen. Gruß, Hagge [Beitrag von hagge am 26. Feb 2017, 12:10 bearbeitet] |

|||||||

|

hmt

Inventar |

#4749

erstellt: 26. Feb 2017, 12:23

|

||||||

|

Nein. Warum? Siehe meine Beiträge weiter oben. Du hast weiterhin nur eine sinnlose Wall of Text ohne Bezug zum Thema (NXP SoCs) gepostet. Jeder ARM SoC hat btw einen Videoprozessor (nebst GPU), daher ist der Themenbezug gleich null. Einen Absatz nehme ich doch heraus, und zwar den bezüglich der GPUs. Der ist grundfalsch. Es IST möglich über die Shadereinheiten einer GPU Videobearbeitung durchzuführen. Fakt. Dass es dazu noch extra Einheiten gibt liegt daran, dass diese effizienter Arbeiten. Im MPC HC auf meinen PC kann ich beim Integrierten Decoder sogar explizit auswählen, ob ich per CPU, dezidierte Einheit der GPU-UVD oder per Pixelshader (zB über die CUDA-Schnittstelle bei NVidia) der GPU decodieren will. Der Rest ist ähnlich falsch bzw an Thema vorbei, deswegen gehe ich da nicht drauf ein. Es geht nur wieder der Hinweis an dich den Artikel mal durchzulesen und zu verstehen. So aufwendig ist DV nicht (bei weitem nicht so aufwendig wie die Decodierung oder gar 3D-Spiele), es hat schon seinen Grund weswegen Dolby DV nun per Software implementieren lässt. Da geht es nicht um eine rein theoretische Überlegung. EDIT: Unnötiges Direkt-Komplettzitat durch die Moderation entfernt! [Beitrag von OSwiss am 26. Feb 2017, 19:08 bearbeitet] |

|||||||

|

Samsung-Klaus

Stammgast |

#4750

erstellt: 26. Feb 2017, 14:09

|

||||||

|

Spencer2k6

Inventar |

#4751

erstellt: 26. Feb 2017, 14:58

|

||||||

|

Drück mal länger die Powertaste auf der Fernbedienung. Dann sollte die Kiste neustarten und das weg sein |

|||||||

|

kamio

Ist häufiger hier |

#4752

erstellt: 26. Feb 2017, 16:54

|

||||||

|

Hallo Samsung-Klaus, genauso habe ich es auch gemacht. Leider hat bis jetzt auf meine Frage wie es richtig geht bis jetzt niemand eine Antwort. Gruß kamio |

|||||||

|

MuLatte

Inventar |

#4753

erstellt: 26. Feb 2017, 19:23

|

||||||

|

Ist das hier Krieg der Vollzitate oder ist das einfach nur Dämlichkeit? |

|||||||

|

hagge

Inventar |

#4754

erstellt: 26. Feb 2017, 21:24

|

||||||

Also das ist nun wirklich komplett falsch. Ich kann Dir aus dem Stegreif zig ARM-SoCs ohne Videoprozessor aufzählen. Und dass es ARM-Cores ohne GPU gibt, hatte ich ja schon in meinem letzten Post aufgezeigt. Und was ist bei Dir überhaupt ein Videoprozessor? Meinst Du einen LCD-Controller? Oder einen LVDS-Controller? Oder einen HDMI-Controller? Oder einen Video-Decoder? Oder einen Videoencoder? Oder einen Bildscaler? Oder einen Bildrotierer? Oder einen Colorspace-Converter? Oder einen Deinterlacer? Oder einen Videomixer? Oder einen Alpha-Channel-Mixer? Oder einen Bittiefen-Konverter? Das alles sind Videoprozessoren in gängigen ARM-SoCs, die aber alle für sich eigene Einheiten sind, wo also auf einem SoC jede für sich vorhanden sein kann oder auch nicht.

Dir ist aber schon klar, dass so eine GPU im ARM-SoC üblicherweise ein bis vier Shader hat, ganz flotte vielleicht 32. Nicht tausende wie eine Grafikkarte im PC? Du denkst viel zu stark in PC-Technik. Man muss mehr in Hardware und spezifischen Verarbeitungseinheiten denken, wenn man in die SoC-Welt geht. Bei den vergleichsweise lahmen Cores und schwachbrüstigen GPUs liefe da sonst gar nichts. Das muss alles in dedizierter Hardware laufen, wenn es schnell gehen soll. Ich habe beruflich jeden Tag mit ARM-SoCs zu tun, weil ich Linux auf die Dinger portiere. So ein klein wenig kenne ich mich da also schon mit aus. Und bei den großen Auflösungen ist da nicht viel in Software zu erreichen. Rechne doch mal selbst. Ein UHD-Bild besteht aus 3840x2160 Pixeln. Nehmen wir weiter an, ein CPU-Core kann immer ein Pixel auf einmal verarbeiten. Das ist nicht trivial, da das Pixel ja aus drei Farben R, G, B besteht. Man braucht also schon Spezialbefehle, um drei solche Komponenten in einem Rutsch bearbeiten zu können. Aber egal, nehmen wir mal an, die NEON-Befehle einer ARM-CPU geben das her. Macht also 8,3 Mio Dateneinheiten (=Pixel). Jetzt muss der Prozessor aber ja nicht nur ein Bild pro Sekunde für Dolby Vision berechnen, sondern bei einem 120Hz-Panel eben 120. Macht ca. 1 Milliarde Pixel pro Sekunde, die verarbeitet werden müssen. Angenommen die Dolby-Vision-Berechnung braucht nur 10 Schritte pro Pixel zur Berechnung, was sicher eine viel viel zu kleine Zahl ist, wahrscheinlich sind es eher Richtung 1000 oder noch mehr. Aber egal, rechnen wir nur mit 10. Dann sind wir bei 10 Milliarden Rechenoperationen pro Sekunde. Nehmen wir weiter an, dass die CPU tatsächlich einen Rechenschritt pro Takt ausführen kann. Tja, wo landen wir dann? Selbst wenn jeder Core mit 1 GHz getaktet ist (was für ARM-Cores schon sehr viel ist), dann sind das zusammen bei einer Quad-Core-CPU trotzdem nur 4 Milliarden Rechenoperationen pro Sekunde, die alle CPU-Cores zusammen liefern können. Also obwohl ich schon sehr optimistische Werte angenommen habe, reicht es trotzdem nicht. Fazit: es ist schlichtweg unmöglich, Dolby Vision per ARM-CPU zu berechnen. Es reicht nicht mal ansatzweise. Ja ich würde behaupten, dass das nicht mal auf einem Core-i7 Kaby-Lake mit acht virtuellen Cores machbar wäre.

*Du* verstehst den Artikel nicht. Bei der genannten Rechenleistung im ZD9 geht es überhaupt nicht um den ARM-SoC, sondern um den X1-Extreme-Prozessor. Das ist ein stark parallel arbeitender Digitaler Signalprozessor (DSP), in dem viele Algorithmen in Hardware implementiert sind. Der hat weder was mit der ARM-CPU, noch der Mali-GPU noch sonst was im ARM-SoC zu tun. Es sind solche Bildengines/DSPs gemeint, wenn von "genug Rechenpower" die Rede ist. Gruß, Hagge [Beitrag von hagge am 26. Feb 2017, 21:31 bearbeitet] |

|||||||

|

Danizo

Inventar |

#4756

erstellt: 27. Feb 2017, 00:44

|

||||||

Q5 !? was hat dein Audi damit zu tun?....du hast den ZD9 in einen SUV eingebaut !? Alter....  (was Q5 ?) Den Film habe ich auch gesehen...mir ist da auch nichts aufgefallen...sorry. Btw. den Film fand ich "schwach"... Greetz |

|||||||

|

hmt

Inventar |

#4757

erstellt: 27. Feb 2017, 10:45

|

||||||

|

@hagge Falsch. Sie auch hier:  http://www.flatpanel...owfull&id=1488181691 http://www.flatpanel...owfull&id=1488181691

Es ist von Rechenleistung die Rede. Was die Shader angeht: Dir ist wohl auch nicht klar, dass für die Bearbeitung und Decodierung von Videos nur ein Bruchteil der Rechenleistung benötigt wird. Zum Rest sage ich mal nichts, denn das ist einfach nur Schwachsinn. Rechenoperationen auf die Taktfrquenz herunterzurechnen (Info: CPUs/GPUs besitzen nicht nur EINE Recheneinheit sondern MEHRERE) ist nur eine Stilblüte, über die man einfach nur den Kopf schütteln kann. Nach der Logik dürfte keines der Geräte ein 3D-Spiel mit genügend FPS darstellen können (denk' doch mal einfach eine Sekunde kurz über solche Plausichecks nach). BTW, schaffte eine 0815 GPU eines Mediatek SoCs 23 GFLOPS. 23 Milliarden Instruktionen pro Sekunde. So viel zu deinem Unsinn (und da habe ich den lahmsten MT SoC aus dem Jahr 2015 genommen, den ich gefunden habe). Ach und da es mir mal eben einfällt. Die Annahme der 120Hz ist auch Unsinn. Das Quellmaterial hat max. 60p, welche bearbeitet werden müssen. 120Hz kommen erst durch die FI zustande. Mir schwirren auch noch weitere Ungereimtheiten in deinen Ausführungen im Kopf, nur wäre ich heute gar nicht fertig, wenn ich die auch noch alle auflisten würde. [Beitrag von hmt am 27. Feb 2017, 10:46 bearbeitet] |

|||||||

|

ToS4

Stammgast |

#4758

erstellt: 27. Feb 2017, 11:52

|

||||||

|

Nur eine freundliche Bitte: Wäre es möglich, diese akademisch hochwertige Debatte in einem Hörsaal einer Universität oder Fachhochschule fortzusetzen und wieder zum Thema "ZD9" zurückzukehren? Ich hoffe, dass das nicht zu viel verlangt ist.  |

|||||||

|

Cinema3D

Inventar |

#4759

erstellt: 27. Feb 2017, 12:04

|

||||||

|

Arbeitskollege hat am Samstag seinen 75er geliefert bekommen. Leider hat der TV extremes DSE/Banding - Gerät stammt übrigens vom Januar 2017. Den ZD9 haben wir dann erst gar nicht an die Wand gehängt - Austausch durch Händler erfolgt angeblich schon innerhalb von 14 Tagen. Kurz zum DSE: Ein solch intensives DSE habe ich schon sehr lange nicht mehr gesehen, schon gar nicht bei einem TV von 6.999€ - anscheinend hat da Sony momentan hart mit zu kämpfen.    |

|||||||

|

Quickiman

Stammgast |

#4760

erstellt: 27. Feb 2017, 12:08

|

||||||

|

ich habe mir eben einen DXW784 und DXW904 als 65er angeschaut. der 784er war leicht betroffen. der 904er so minimal, dass ich ihn direkt mitgenommen hätte... hoffentlich gibts bei mir kohle zurück. dann wars das mit sony |

|||||||

|

Samsung-Klaus

Stammgast |

#4761

erstellt: 27. Feb 2017, 18:20

|

||||||

Bitte mal auf Karton Aufkleber schauen ob da was von Frankreich Herkunft ersichtlich ist bei dem 75. er Meine beide kamen von da DSE verseucht |

|||||||

| |||||||

|

|

||||

Gehe zu Seite: |vorherige| Erste .. 50 . 60 . 70 . 80 . 88 89 90 91 92 93 94 95 96 97 . 100 . 110 . 120 . 130 .. Letzte |nächste|

| Das könnte Dich auch interessieren: |

|

Sony 2017 XE94 75" mit DolbyVision Ralf65 am 05.01.2017 – Letzte Antwort am 23.02.2022 – 2614 Beiträge |

|

Sony 2017 XE93 55"/65" mit DolbyVision Ralf65 am 05.01.2017 – Letzte Antwort am 20.11.2024 – 10429 Beiträge |

|

Sony ZD9 vs. XE94 calabrese am 29.03.2017 – Letzte Antwort am 03.07.2017 – 15 Beiträge |

|

Sony 2018 ZF9 FALD 65" / 75" eARC Ralf65 am 02.02.2018 – Letzte Antwort am 24.10.2024 – 3621 Beiträge |

|

Sony 2019 XG85 55" 65" 75 85" Ralf65 am 08.01.2019 – Letzte Antwort am 02.06.2020 – 87 Beiträge |

|

Der Sony ZD9 Erfahrungsthread Rotti1975 am 01.09.2016 – Letzte Antwort am 23.11.2016 – 7 Beiträge |

|

Haltbarkeit Sony ZD9 schwerhoerig am 12.06.2021 – Letzte Antwort am 16.06.2021 – 4 Beiträge |

|

Sony 2019 ZG9 85"/98" 8k TV (X-Wide Angle, Multi Acoustic Audio, Backlight Master Drive) Shaoran am 08.01.2019 – Letzte Antwort am 22.02.2019 – 11 Beiträge |

|

Sony 2021 X95J 4K 65", 75", 85" Ralf65 am 07.01.2021 – Letzte Antwort am 21.09.2024 – 2900 Beiträge |

|

Sony ZD9 "65 Zoll" defekt! Kein Bild! Ton funktioniert. Snorre666 am 23.02.2024 – Letzte Antwort am 28.02.2024 – 5 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in Sony der letzten 7 Tage

- Sony 55XH9005 ausgeprägte dunkle Ecken

- KDL-75W855C blinkt 6 mal rot

- Sony 2023 MiniLED X95L 65", 75", 85"

- Haben Sony-TV bei Kauf eine Display-Schutzfolie?

- Sony 2017 XE93 55"/65" mit DolbyVision

- KDL-55W805C - LED blinkt 6 mal rot - Totalschaden

- APPs installieren KD-65XF7005

- Sony: Bildeinstellungen erklärt oder "das perfekte Bild"

- XH90 / XH92 Settings Thread

- Netflix-App auf Sony-Bravia gibt IMMER 5.1 aus

Top 10 Threads in Sony der letzten 50 Tage

- Sony 55XH9005 ausgeprägte dunkle Ecken

- KDL-75W855C blinkt 6 mal rot

- Sony 2023 MiniLED X95L 65", 75", 85"

- Haben Sony-TV bei Kauf eine Display-Schutzfolie?

- Sony 2017 XE93 55"/65" mit DolbyVision

- KDL-55W805C - LED blinkt 6 mal rot - Totalschaden

- APPs installieren KD-65XF7005

- Sony: Bildeinstellungen erklärt oder "das perfekte Bild"

- XH90 / XH92 Settings Thread

- Netflix-App auf Sony-Bravia gibt IMMER 5.1 aus

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder927.753 ( Heute: 6 )

- Neuestes MitgliedMoving_Coil

- Gesamtzahl an Themen1.556.424

- Gesamtzahl an Beiträgen21.658.499