| HIFI-FORUM » Fernseher & Beamer » Projektoren / Beamer » High Dynamic Range: Wie hell müssen Projektoren fü... | |

|

|

||||

High Dynamic Range: Wie hell müssen Projektoren für HDR sein?+A -A |

||||||||||||||||||

| Autor |

| |||||||||||||||||

|

Cale

Stammgast |

#210

erstellt: 21. Mrz 2016, 11:48

|

|||||||||||||||||

|

Hi Ekki! Vielleicht hilft ja ein simples Beispiel um zu verstehen, was der JVC macht. Nehmen wir mal an, ein HDR Film wird auf einem Display gemastert und in einer Szene soll der Hintergrund 100 Nits haben und zusätzlich strahlt eine Sonne mit 1000 nits. Was macht dann der JVC, der nur ca 100 nits erreicht daraus? [Beitrag von Cale am 21. Mrz 2016, 11:48 bearbeitet] |

||||||||||||||||||

|

Houbi

Inventar |

#211

erstellt: 21. Mrz 2016, 12:10

|

|||||||||||||||||

...? Was war nun genau die Motivation Deep Color zu aktivieren? Wenn ich nicht irre ist das ein Überbleibstel aus längst vergangenen Zeiten aber mit dem neuen 4K UHD BD Standard hat das doch nichts zu tun? |

||||||||||||||||||

|

|

||||||||||||||||||

|

max25game

Stammgast |

#212

erstellt: 21. Mrz 2016, 12:12

|

|||||||||||||||||

|

also ich finde ihr wart beide sachlich...da kommt wohl was aus der Vergangenheit hoch.  ich finde vor allem diesen Smiley =>  ,äußerst überheblich. Kann ich nicht ausstehen das Teil, den verwende ich nie...geht aber vielleicht nur mir so. ,äußerst überheblich. Kann ich nicht ausstehen das Teil, den verwende ich nie...geht aber vielleicht nur mir so.@Cale auch so ein Punkt der mir noch nicht so einleuchtet, ich hab wohl auch zu wenig Nits  |

||||||||||||||||||

|

George_Lucas

Inventar |

#213

erstellt: 21. Mrz 2016, 12:26

|

|||||||||||||||||

|

@Houbi So lange es keine verbindlichen Standards gibt, machen die Hersteller leider was sie wollen - und zwar über den gesamten Produktionsprozess hinweg. Ohne Standards ist eine Anpassung des Displays sinnfrei, weil das Bildergebnis kaum dem "Original" entsprechen kann. Aus diesem Grund wird jetzt an allen Ecken "gebastelt", um ein weitgehend zufriedenstellendes Bildergebnis zu erhalten. Bedauerlicherweise wird das noch so lange weiter gehen, bis endlich mal allgemein verbindliche Standards existieren, an die sich alle Unternehmen halten können, die am Broadcast bis zum Wiedergabeprozesses beteiligt sind. Die unterschiedlichen Nit-Angaben für unterschiedliche Display-Techniken sind nur eine Baustelle. [Beitrag von George_Lucas am 21. Mrz 2016, 12:28 bearbeitet] |

||||||||||||||||||

|

Houbi

Inventar |

#214

erstellt: 21. Mrz 2016, 12:28

|

|||||||||||||||||

|

@George_Lucas: Genau so siehts aus, da kann ich nur zustimmen. [Beitrag von Houbi am 21. Mrz 2016, 12:29 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#215

erstellt: 21. Mrz 2016, 13:23

|

|||||||||||||||||

Der "niedrige" An/Aus-Kontrast macht ihn zu einem SDR-Gerät. Ich habe nie geschrieben, dass das BT.709-Gamma geeigneter wäre, HDR wiederzugeben. Das ist ja auch Quatsch, weil die HDR-Quelle nun mal mit ST2084 kodiert vorliegt. Die Gammakurve muss aber so angepasst werden, dass der generelle Bildeindruck erhalten bleibt. Und das passiert ja anscheinend nicht. Oder "Exodus" soll in HDR ganz anders aussehen. Diese Möglichkeit ist auch nicht ausgeschlossen. Jedenfalls geht es bei HDR nicht darum, einen Film einfach mit einer anderen Gradationskurve darzustellen, sondern einen großen Bereich über der herkömmlichen Maximalhelligkeit (100 Nits) für Spitzlichter zu benutzen. Dafür benötigt das Anzeigegerät aber auch zwingend diesen hohen Kontrast. Und den hat kein Konsumerprojektor.

Nach meinem Kenntnisstand gibt es zwei Mindestanforderungen. Eine für besonders helle Anzeigegeräte (z.B. TVs), die 20.000 : 1 umfasst und eine für dunklere (z.B. OLED), die mit 1.080.000 : 1 deutlich strenger ist. Für Projektoren ist mir nichts bekannt. Diese Mindestanforderungen erinnern aber sehr stark an "HD Ready" und sind dem aktuellen Technologiestand angepasst. Dolby Vision z.B. spezifiziert 10.000.000 : 1. Das meinte ich mit "vollem HDR".

Genau. Man kann zwar ein ST2084-Inhalt auf einem herkömmlichen Anzeigegerät darstellen, aber der "Rendering Intent" (Clipping, S-Kurve usw.) ist völlig unklar. |

||||||||||||||||||

|

leon136

Hat sich gelöscht |

#216

erstellt: 22. Mrz 2016, 15:43

|

|||||||||||||||||

|

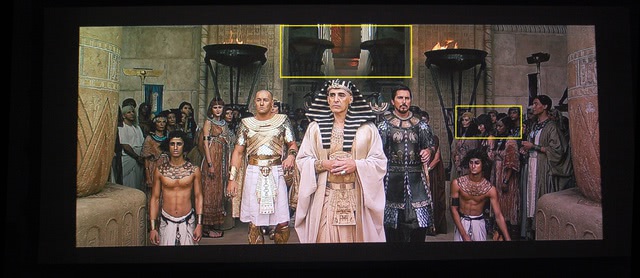

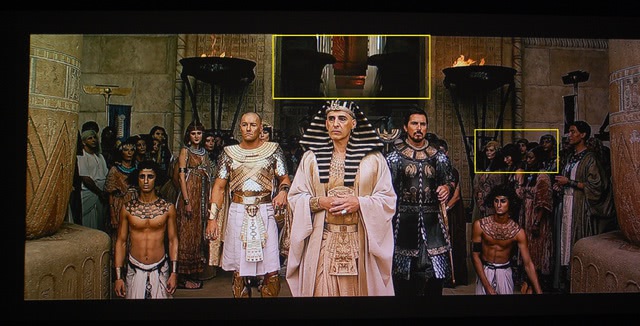

Hab noch mal ein wenig umhergespielt was es für Auswirkungen hat wenn Beamer und Player sich nicht einigen in Punkto RGB /HDMI-Level und Gamma. Vordergrund ganz ok aber alles im Halbschatten versumpft. Ich glaube das ist genau das Problem mit Samsung und VW520 / X7000 ohne starke Korrekturen geht das nicht mit einem Werkspreset.   |

||||||||||||||||||

|

Cale

Stammgast |

#217

erstellt: 22. Mrz 2016, 17:26

|

|||||||||||||||||

Ich zitiere mich mal selber, weil ich vermutlich eine Antwort auf die Frage gefunden habe. Auf der folgenden Seite wurde der X7000 mit dem Samsung Player getestet und zusammen mit Peter Hess von JVC die Einstellungen vorgenommen.  http://www.lowbeats....500-jvc-dla-x7000/3/ http://www.lowbeats....500-jvc-dla-x7000/3/Dort wird beschrieben, dass der JVC so eingestellt wird, dass der JVC den Bereich über 100 Nits einfach kappt, das Signal also übersteuert. Auf mein Beispiel angewendet hätte man einen Hintergrund mit 100 Nits und eine Sonnne mit 100 Nits. Die daraus resultierenden Nachteile werden in dem Test ebenso beschrieben. Da der JVC bestimmt von den 10/12 bit profitiert und zudem vermutlich den unteren Helligkeitsbereich von HDR wiedergeben kann, würde ich auch nicht von einen SDR Gerät sprechen, aber vermutlich auch nicht von einem richtigen HDR Gerät. |

||||||||||||||||||

|

max25game

Stammgast |

#218

erstellt: 22. Mrz 2016, 17:48

|

|||||||||||||||||

|

einigen wir uns vorläufig auf Low-HDR...Premium  |

||||||||||||||||||

|

golf187

Inventar |

#219

erstellt: 22. Mrz 2016, 17:56

|

|||||||||||||||||

|

jaaa der war gut. fällt nur das H weg ahahahahahaaa  |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#220

erstellt: 22. Mrz 2016, 18:13

|

|||||||||||||||||

Ja, mir wurde von einem freundlichen Forumskollegen eine Messung geschickt, die das bestätigt. Dort knickt die Gammakurve obenrum etwas ab und geht dann bei 45% ins Clipping. Ähnlich wie  hier beschrieben. Ob 45% allerdings 100 Nits entsprechen sollen, weiß ich nicht. Bei Light Illusion wird von 50% beim BBC-Standard gesprochen. Weiß da jemand genaueres bezüglich ST2084? hier beschrieben. Ob 45% allerdings 100 Nits entsprechen sollen, weiß ich nicht. Bei Light Illusion wird von 50% beim BBC-Standard gesprochen. Weiß da jemand genaueres bezüglich ST2084?Das Clipping alleine erklärt aber noch nicht den stark unterschiedlichen Bildeindruck zwischen der HDR- und der SDR-Blu-ray auf dem JVC bezüglich der Gradation (Farbraum natürlich ausgeschlossen). Mögliche Gründe, die mir einfallen:

Was davon zutrifft, wissen wir aktuell nicht. [Beitrag von FoLLgoTT am 22. Mrz 2016, 18:14 bearbeitet] |

||||||||||||||||||

|

Houbi

Inventar |

#221

erstellt: 22. Mrz 2016, 18:17

|

|||||||||||||||||

Kann ich soweit nur bestätigen. Daher ja auch der Workaround mit HDMI dynamic range auf Full am Beamer resp. RGB (Limited) am Samsung Player. |

||||||||||||||||||

|

George_Lucas

Inventar |

#222

erstellt: 22. Mrz 2016, 18:38

|

|||||||||||||||||

Was sich mir die ganze Zeit nicht erschließt: Warum wird die Videorange von "Full" auf "Begrenzt" geschaltet? "HDR 10" ermöglicht bis zu 1024 Grauabstufungen mit 10 Bit. Es macht meiner Meinung nach überhaupt keinen Sinn, das jetzt händisch wieder zu verrringern, weil der Projektor nicht imstande ist, die volle Videorange fehlerfrei auf der Leinwand darzustellen. Das ist doch alles irgendwie totaler Murx! |

||||||||||||||||||

|

Jogitronic

Inventar |

#223

erstellt: 22. Mrz 2016, 18:47

|

|||||||||||||||||

Zur Erläuterung  Klick KlickGruß, Ex... |

||||||||||||||||||

|

Houbi

Inventar |

#224

erstellt: 22. Mrz 2016, 19:05

|

|||||||||||||||||

Ich denke nicht das hier der Projektor was falsch macht. Quelle des Unheils ist meiner Meinung nach ganz klar der Samsung Player. Totaler Murx nicht, ich bleibe meiner Aussage "Format der Zukunft". Aber zur Zeit sind teils noch viel Geduld und gewisse Kentnisse gefragt. Es ist eben noch nicbt alles perfekt. Wir haben vorgestern seit einer Weile mal wieder eine normale Blu Ray geschaut. Im Vergleich zur 4K BD kommt das alles relativ "blass" und leblos rüber, teilweise könnte man fast schon "Grauschleier" in den Mund nehmen. Der Inbildkontrast des neuen Formats begeistert, keine Frage. [Beitrag von Houbi am 22. Mrz 2016, 19:06 bearbeitet] |

||||||||||||||||||

|

George_Lucas

Inventar |

#225

erstellt: 22. Mrz 2016, 19:17

|

|||||||||||||||||

|

@Houbi, wie sieht das Bild der Blu-ray vergleichsweise aus, wenn Du den Projektor auf den Bildmodus "User 1" stellst - und statt Rec.709 einen erweiterten Farbraum nutzt? |

||||||||||||||||||

|

leon136

Hat sich gelöscht |

#226

erstellt: 22. Mrz 2016, 19:52

|

|||||||||||||||||

Das liest sich so (wenn richtig  ) das man auch einen Projektor z.B. mit Adobe Farbraum und genug "Bums" (Helligkeit) an die neue Scheibe anpassen ) das man auch einen Projektor z.B. mit Adobe Farbraum und genug "Bums" (Helligkeit) an die neue Scheibe anpassenkönnte, wenn ! ich bei einem UHD-Player die Ausgabe von HDR erzwingen kann ohne das dies vorher explizit zwischen den Geräten ausgetauscht werden muss. Z.B. bei einem VW1100. |

||||||||||||||||||

|

Houbi

Inventar |

#227

erstellt: 22. Mrz 2016, 20:00

|

|||||||||||||||||

Hi "user 1"? Ich habe "Film 1" oder "User". Für UHD BD's nutze ich User, für Blu-Rays ab oppo kommt "Bright Cinema" zum Einsatz. Für BD's als auch 4K BD's nutze ich Farbraum 2 (bei 4K BD's ist das eine Zwischenlösung). Das Rec.709 Preset nutze ich nie. Jedes meiner Quell Geräte hat durchs Band (Beamer, Vorstufe, etc.) dedizierte Settings und das wird alles voll automatisch geschaltet. [Beitrag von Houbi am 22. Mrz 2016, 20:23 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#228

erstellt: 23. Mrz 2016, 08:39

|

|||||||||||||||||

|

Einen Absatz aus Raphael Vogts Artikel finde ich übrigens besonders interessant:

Entweder geht der JVC zu früh ins Clipping oder Clipping alleine ist grundsätzlich nicht die optimale Lösung. Denn wenn der Film nicht sauber gemastert wurde (und das gängig werden sollte) und Details in dem Bereich >100 Nits verschwinden würden, dann wäre eine leichte S-Kurve plus Clipping möglicherweise die bessere Alternative. Oder anders gesagt: das Anzeigegerät müsste einen Teil des Bereichs über 100 Nits komprimieren und ihn unter 100 Nits darstellen, um Details zu erhalten. Mal schauen, wie das final gelöst wird... [Beitrag von FoLLgoTT am 23. Mrz 2016, 08:43 bearbeitet] |

||||||||||||||||||

|

Nudgiator

Inventar |

#229

erstellt: 23. Mrz 2016, 12:01

|

|||||||||||||||||

Da bin ich selbst gespannt. Hab mich da auch schon mit Light-Illusion drüber unterhalten. Der Tenor war dort eindeutig: man muß hier zwangsläufig Kompromisse eingehen. Bin da aber noch guter Dinge, das wir da eine Lösung finden werden. Ein Kollege von mir besitzt einen X9000 und experimentiert selbst mit HDR/DCI etc. Aktuell konzentriere ich mich lieber darauf, daß DCI auf dem X7000 vernünftig dargestellt wird und kalibriert werden kann. HDR kann man vorerst auch deaktivieren und eine herkömmliche Gammakurve nutzen (welche Gammakurve ist für DCI eigentlich vorgesehen? Ich denke mal ein normales Power-Gamma mit 2.2). |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#230

erstellt: 23. Mrz 2016, 12:06

|

|||||||||||||||||

Für DCI ist eine Potenzfunktion mit dem Exponenten 2,6 spezifiziert. |

||||||||||||||||||

|

George_Lucas

Inventar |

#231

erstellt: 23. Mrz 2016, 13:45

|

|||||||||||||||||

Mit dieser Aussage hat FoLLgoTT völlig recht. Nur sollte auch darauf hingewiesen werden, dass die fürs Kino spezifizierten DCPs auf den Heimkino-Projektoren nicht abspielbar sind. Die DCI-Norm spezifiziert ja nicht nur das Gamma (2,6), sondern auch die Farbraumkoordinaten und den Weißpunkt (5500 Kelvin). DCI fürs Kino und UHD fürs Heimkino sind verschiedene Standards. Insofern macht es überhaupt keinen Sinn, den Heimkino-Projektor auf die DCI-Spezifikation hin zu kalibrieren, wenn damit Blu-rays oder 4K-Blu-rays projiziert werden. Für das Hometheater gibt es die UHD-Spezifikation, in der der Farbraum Rec.2020 festgeschrieben worden ist. Ob die 4K-Blu-ray innerhalb dieses Farbraums nur die DCI-Farbraum-Koordinaten nutzt, ist bislang unklar wegen des bislang fehlenden HDR-Standards. |

||||||||||||||||||

|

max25game

Stammgast |

#232

erstellt: 23. Mrz 2016, 14:21

|

|||||||||||||||||

aber das ist ja auch so ein Thema, wenn ich da die Eindrücke vom R.Vogt-Test lese...

...und die Bemerkung von Ekki das ein Rotstich bei X7000/VW520 in den Werkspresets vorhanden war, hier wird kein Wort darüber verloren. Gehört das also gar nicht so "mega-satt Rot"? Vermutlich nicht. Ich gehe hin und wieder gerne ins Kino, da sind die Farben einfach lebendiger und kräftiger, aber nicht so das ein "mega" Unterschied auffallen würde. |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#233

erstellt: 23. Mrz 2016, 14:32

|

|||||||||||||||||

Nein und Ja.  Es spricht nichts dagegen, DCI-Material auf einem korrekt kalibrierten Heimkinoprojektor abzuspielen. Gamut, Weißpunkt und Gamma lassen sich ja alle hinbiegen. Und es gibt sogar  DCP-Player für Windows. Also grundsätzlich kann man mit jedem Heimkinoprojektor DCI-Material abspielen. DCP-Player für Windows. Also grundsätzlich kann man mit jedem Heimkinoprojektor DCI-Material abspielen.Aber du hast natürlich völlig Recht, dass so eine Kalibrierung totaler Quatsch ist, wenn der Film in BT.709 oder BT.2020 vorliegt. Aber das hat eigentlich auch niemand gefordert.

Das Anzeigegerät "weiß" von dem Zielfarbraum nichts. Es werden bisher nur nackte YCbCr-Daten übermittelt und die sehen für alle Farbräume gleich aus. Metadaten, für welchen Farbraum diese Daten gedacht sind, gab es bisher nicht. Ich meine aber mal irgendwo gelesen zu haben, dass sich das auch ändern soll(te). Wäre zumindest mal ein echter Fortschritt... PS: Player/Renderer am PC schätzen bisher anhand der Quellauflösung den Zielfarbraum (BT.601 oder BT.709) ab. Ab 720 vertikal schalten viele auf die Koeffizienten von BT.709 für die RGB-Transformation. [Beitrag von FoLLgoTT am 23. Mrz 2016, 14:52 bearbeitet] |

||||||||||||||||||

|

George_Lucas

Inventar |

#234

erstellt: 23. Mrz 2016, 15:01

|

|||||||||||||||||

Theoretisch ist das technisch möglich; da hast Du Recht. Aber Kinobetreiber erhalten in der Regel keinen "Schlüssel", geschweige denn ein DCP, wenn sie die DCI-Spezifikation im Kino nicht erfüllen. Insofern wird ein Laie mit Heimprojektor kaum ein Kino-DCP vom Verleiher/Studio erhalten, welches den DCI-Standard besitzt. [Beitrag von George_Lucas am 23. Mrz 2016, 15:03 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#235

erstellt: 23. Mrz 2016, 15:21

|

|||||||||||||||||

Dass kein Material frei verfügbar ist, ist ja ein ganz anderes Thema. Es spricht aber auch nichts dagegen, sich selbst DCPs zu erstellen (z.B.  hier mit). hier mit). |

||||||||||||||||||

|

Master468

Inventar |

#236

erstellt: 23. Mrz 2016, 15:37

|

|||||||||||||||||

Der Weißpunkt ist erstmal unproblematisch. Unterschiede zwischen Referenz- und Reproduktionsweißpunkt lassen sich durch eine einfache Skalierungsoperationen oder, wenn möglich, eine chromatische Adaption, gut angleichen. Das ist in Anwendungen für die grafische Industrie Alltag. Im Videobereich ist die Philosophie zwar ein wenig anders - allerdings nicht aus wahrnehmungsphysiolgischen Gründen.

Man müsste das Rad noch nicht einmal neu erfinden. Für die Charakterisierung der Daten würde ein an das ICC Matrix/ Shaper Modell angelehnter Ansatz völlig ausreichen. Aber falls etwas in dieser Form wirklich umgesetzt werden sollte, wird in jedem Fall noch viel Wasser den Rhein hinunterfließen. Ebenso wichtig wäre aber zumindest eine Empfehlung für das Gamut-Mapping auf den meist kleineren Gerätefarbraum (zumindest im Hinblick auf Rec. 2020). Damit kann man in Tateinheit dann auch gleich das HDR-Matching definieren. Wie von dir angedeutet, bleibt es letztlich bei der Entscheidung zwischen Kompression oder farbmetrischer Wiedergabe in den entscheidenden Mitteltönen und Tiefen. Im Medizinbereich weist die DICOM Tonwertkurve einige Parallelen auf (absoluter Charakter), allerdings ist der hier gewählte Ansatz für die Kalibration (Ausschnittsbetrachtung und Gleichverteilung der zur Verfügung stehenden Tonwerte) aufgrund anderer Prämissen nicht sinnvoll übertragbar.

Mit welchen Intent ein Gamut-Mapping durchgeführt wird, lässt sich in der Tat sehr einfach aus der Zuspielung von Testformen ableiten. Aber das hilft bei der Kalibration im hier besprochenen Szenario (Quellfarbraum > Zielfarbraum; dazu zählt auch DCI in Rec. 2020) dann auch nicht weiter, da du mit einem normalen CMS entsprechende Transformationen nicht nachstellen kannst. Ausnahme: Es handelt sich um die "Holzhammermethode", d.h. eine bestmögliche Annäherung der Primärfarben. Das verspricht aber gute Ergebnisse nur bei einer lediglich geringen Unterabdeckung.

Die wird in der Regel auch vom Scaler maskiert. Eine natives Setting ist gemeinhin unüblich. Wie auch immer: Die LC-Panelhersteller garantieren über Korrekturtabellen meist eine Vorlinearisierung mit Gamma 2.2 Tonwertkurve und D65 Weißpunkt. Allerdings sind die Toleranzen ziemlich groß. Das könnte bei den Projektor-Panels ähnlich aussehen. Gruß Denis [Beitrag von Master468 am 23. Mrz 2016, 15:41 bearbeitet] |

||||||||||||||||||

|

max25game

Stammgast |

#237

erstellt: 23. Mrz 2016, 15:41

|

|||||||||||||||||

ja, so ein bidirektionaler Austausch von Anzeigegerät, Zuspieler und Quellmaterial wär mal was. Hab da auch was gelesen das u.a. Sony an was dran ist...ob das wieder nur ne Insellösung für die jeweiligen Hersteller-Produkte ist, wird man sehen. |

||||||||||||||||||

|

max25game

Stammgast |

#238

erstellt: 23. Mrz 2016, 16:08

|

|||||||||||||||||

|

Oh mein Gott, Denis...bei deinen Beiträgen raucht mir immer der Schädel

Also könnte (vorausgesetzt das "BT.2020 auf DCI"-Werkspreset ist schon nahe am Soll) ich mit der Holzhammermethode, per internem CMS oder 3D-LUT bei dem transformierten Farbraum kleinere Korrekturen vornehmen, bzw. mich orientieren, was da überhaupt rauskommt, bei der Transformation? Was bitte ist eine geringe Unterabdeckung? Danke und Gruß Markus |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#239

erstellt: 23. Mrz 2016, 16:15

|

|||||||||||||||||

Ja, das denke ich auch. Wobei es mich wundert, warum man in den höherpreisigen Projektoren nicht mal die Möglichkeit schafft, 3D-LUTs hochzuladen. Professionelle Monitore können das ja auch. Stattdessen muss man umständlich in den Menüs rumfummeln, was, wie du auch schreibst, für spezielle Rendering Intents nicht ausreicht. Da merkt man eben, dass das Zielpublikum ein anderes ist als im professionellen Bereich...

Ich meinte mit "intern" den gesamten Projektor als "Black Box". Also eine herkömmliche Messung mit HDR-Patterns. Die Entzerrung für das Panel ist für uns natürlich wenig interessant.  [Beitrag von FoLLgoTT am 23. Mrz 2016, 16:16 bearbeitet] |

||||||||||||||||||

|

Nudgiator

Inventar |

#240

erstellt: 23. Mrz 2016, 18:50

|

|||||||||||||||||

Aber genau das ist doch der Punkt: wo kommen denn die Filme für die UHD her? Das dürfte wohl die DCI-Version für das Kino sein. Ich kann mir beim besten Willen nicht vorstellen, daß man diese DCI-Version für die UHD nach BT.2020 transformiert und das Zielgerät transformiert dann wieder zurück nach DCI. Was bleibt also im Moment? Man schaut einfach mal, wo die Zielpunkte im HDR-DCI-Bildmodus liegen ... die Vermutung liegt wohl nahe, daß diese mit den DCI-Zielpunkte übereinstimmen. Also versucht man erstmal auf diese Punkte zu kalibrieren. Was willst Du sonst machen? |

||||||||||||||||||

|

mule

Hat sich gelöscht |

#241

erstellt: 23. Mrz 2016, 19:23

|

|||||||||||||||||

Genauso würde ich die bisher vorliegenden Infos interpretieren: auf der UHD ist immer BT2020, daher wird das DCi-Master für die UHD nach BT.2020 transformiert und anschließend vom Wiedergabegerät wieder zurück auf den jeweils eingestellten Farbraum. Beim X7000 dann halt nahe DCI. BT2020 wäre damit der gemeinsame Nenner zwischen allen Playern und Wiedergabegeräten. Ob das Hin- und Hertransformieren der Bildqualität zuträglich ist, steht natürlich auf einem anderen Blatt. Mag aber auch sein, das ich mit dieser Interpretation der bisherigen Infos falsch liege. [Beitrag von mule am 23. Mrz 2016, 19:24 bearbeitet] |

||||||||||||||||||

|

lappy67

Stammgast |

#242

erstellt: 23. Mrz 2016, 19:29

|

|||||||||||||||||

|

Mal ne ganz doofe Frage. Wenn der Beamer nicht genug Helligkeit auf der Leinwand für HDR anzeigen kann, warum dann nicht mal versuchen eine spezielle HDR Leinwand entwickeln? Gibts ja auch für helle Räume. Warum dann nicht eine Spezielle für HDR? [Beitrag von lappy67 am 23. Mrz 2016, 19:29 bearbeitet] |

||||||||||||||||||

|

hajkoo

Inventar |

#243

erstellt: 24. Mrz 2016, 14:00

|

|||||||||||||||||

|

Was soll die Deiner Meinung nach für Eigenschaften haben? so long... |

||||||||||||||||||

|

sacx

Stammgast |

#244

erstellt: 24. Mrz 2016, 14:47

|

|||||||||||||||||

|

Eine graue Leinwand, die das Schwarz "schwärzer" macht und durch eingelagerte Silber/Glas-Partikel das weiß "strahlender". Damit könnte man in beide Richtungen etwas hinzugewinnen. Ich fände es interessant, das mal beim HDR-Workshop in Uhingen im "Wohnzimmerkino" mit der SuperNova-Leinwand auszuprobieren. |

||||||||||||||||||

|

Cine4Home

Gesperrt |

#245

erstellt: 24. Mrz 2016, 15:06

|

|||||||||||||||||

Genau die Möglichkeit, dass die HDR Version in einigen Szenen anders aussehen soll, würde ich auch nicht ausschließen, darum geht es ja eigentlich. Es ist auch keinesfalls so, dass sie grundsätzlich total anders aussieht. Eine wichtige Frage ist, ob die SDR Version tatsächlich die "richtige" ist und als absolute Referenz herhalten kann. Im direkten Vergleich hatten wir kollektiv nämlich nicht den Eindruck. Groß sind auch hier die Kompromisse der SDR Version auf HDR Displays. Und es ist auch schon länger bekannt, dass die Filmemacher sich daran stören, dass das veraltete CRT-Gamma seit Jahren keine authentischen Ergebnisse mehr auf den "hochgezüchteten" TVs bietet. Das ist einer der Hauptgründe für den Wechsel zu HDR.

Ich glaube man muss hier sehr genau mit den Begriffen agieren. Der native Kontrastumfang des JVCs ist dem selbst von teuren HDR-Fernsehern nicht wirklich unterlegen, genau das Gegenteil. Aber das ist ja nicht das einzige Kriterium für HDR.

Richtig, es bleibt uns also nichts anderes übrig, als die Anforderungen an TVs mit dem der Beamer zu vergleichen. Erste Anforderung im Kontrast erfüllt der JVC locker, übertrifft die um mehrere Faktoren. Von der der zweiten Anforderung ist er auch nicht weit entfernt. Was bleibt ist die Bewertung der Helligkeit. Da haben wir für Projektoren nur einen Richtwert von Dolby, der bei 32ftl oder so liegt. Dieser im Vergleich zu TVs niedrige Wert berücksichtigt natürlich die technischen Limitationen von Projektoren, aber er "funktioniert" in der Praxis mit HDR, wie man sich selbst im Kino von überzeugen kann. Wir brauchen sicherlich nicht 500ftl bei einer blickfüllenden Leinwand.

Ja, das mit dem "HD(R)ready" Vergleich ist so abwegig nicht. Das gilt aber eigentlich für alle TVs und Beamer, kein Gerät erfüllt das gewünschte Optimum. Niemand sagt, dass HDR jetzt perfekt ausgereizt wird, ich habe mich nur daran gestört so pauschal von "richtig" oder "falsch" zu reden. Die JVC ist den meisten HDR-TVs in Teilen des Dynamikumfangs deutlich überlegen. Und um bei deinem Vergleich zu bleiben: HDready war definitiv schon deutlich besser als SD  10,000,000:1 ? Als Endziel? Bisher haben sie doch immer 1,000,000:1 proklamiert (vielleicht habe ich was übersehen)? Dass bei Dolby auch viel Marketing im Spiel ist, wissen wir glaube ich alle. Ich bezweifle ehrlich gesagt, dass real irgendein Kino den einen oder anderen Wert erreicht. Aber das ist eine Unterstellung meinerseits  Zu diskutieren wäre auch, bei welchen Bildinhalten dieser Unterschied bei gleicher Helligkeit überhaupt zum Tragen käme. Bei einem Beamer??? Zu diskutieren wäre auch, bei welchen Bildinhalten dieser Unterschied bei gleicher Helligkeit überhaupt zum Tragen käme. Bei einem Beamer???

Zweifelsohne, aber wo hört das "herkömmliche Anzeigegerät" auf und wo fängt "HDR tauglich" an? Das ist doch die entscheidende Frage. Viele Grüße, Ekki [Beitrag von Cine4Home am 24. Mrz 2016, 15:17 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#246

erstellt: 24. Mrz 2016, 16:06

|

|||||||||||||||||

Da gebe ich dir Recht. Eine Referenz ist die Blu-ray sicher nicht. Das wäre wohl eher die DCI-Version. Aber selbst das muss nicht so sein, wenn die HDR-Version bewusst anders aussehen soll. Aber wie gesagt, die andere Gammakurve ändert ja erstmal nichts am Bildeindruck bezüglich der Gradation (also die Steilheit der Kontraste, Sättigung usw.). Denn die Kurven sind ja auf beiden Seiten, also Encoding und Decoding, invers zueinander und gleichen sich aus. Unterschiedliche Gammakurven nutzen nur die Tonwerte unterschiedlich gut aus, was Banding reduziert oder verstärkt. Falls es das ist, was du mit "authentisch" meinst, so stimme ich dir zu.

Mit dynamischer Blende, ja. Ohne ist der Kontrast immerhin noch um den Faktor 10 geringer. Davon bin ich ausgegangen. Von mir aus können wir aber auch von eingeschalteter ausgehen.

Da stimme ich dir zu. In einer optimierten Umgebung ohne Restlicht ist die Erweiterung nach unten hin sicherlich sinnvoller als nach oben. 32 fL erzeugen ein angenehm helles Bild. Allerdings sind die JVCs für größere Leinwände nach wie vor zu dunkel, um das zu erreichen. Und erst Recht, um einen Großteil des Helligkeitsbereiches für Spitzlichter zu reservieren.

Ich hatte den Kontrast aus dem  White Paper aus dem Technologiebalken errechnet. Übrigens hatte ich eine Null vergessen. White Paper aus dem Technologiebalken errechnet. Übrigens hatte ich eine Null vergessen.  Da steht aber auch drin, dass die realen Anzeigegeräte deutlich weniger abdecken (müssen?). Die heutigen Limitierungen sind für mich aber kein Grund, nicht das Maximum als erstrebenswertes Ziel anzusehen. Das Endziel sollte sich nicht nach dem technologischen Stand richten, sondern umgekehrt. Aber gut, ohne eine Spezifikation für die Blu-ray ist das sowieso alles nur Rumgespinne...

Naja, mein alter Röhrenprojektor hatte einen An/Aus-Kontrast von >1.000.000 : 1 (war der damit auch HDR-tauglich?  ). Der Schwarzwert war nicht mehr messbar und erst nach mehreren Minuten Adaption minimal sichtbar. Für durchschnittlich dunkle Filme ist ein hoher Kontrast definitiv von Vorteil, das hat man auf der Röhre immer schön gesehen. ). Der Schwarzwert war nicht mehr messbar und erst nach mehreren Minuten Adaption minimal sichtbar. Für durchschnittlich dunkle Filme ist ein hoher Kontrast definitiv von Vorteil, das hat man auf der Röhre immer schön gesehen.Die gleichzeitige Darstellung von extrem hellen Partien ist aber wohl eher weniger sinnvoll. Das macht das Auge ja schon nicht mit bzw. die dunklen Partien saufen ab, wenn sich das Auge an die hellen gewöhnt usw. Ich sehe daher den hohen Kontrast eher als Vorteil für unterschiedlich durchschnittlich helle Szenen und nicht innerhalb einer besonders kontrastreichen Szene.

Abgesehen vom Kontrast (bei dem JVC ja zugegebenermaßen mit eingeschalteter Blende durchgehen könnte), ist für meinen Anspruch die Lichtleistung noch zu gering. Einen großen Bereich für Spitzlichter zu reservieren, ist bei größeren Leinwänden einfach nicht drin. Größere Leinwand heißt für mich ab 3,5 m Breite aufwärts. Das ist heutzutage in Kellerkinos keine Seltenheit mehr. Dazu kommt noch ein niedriger Gain durch akustisch transparente Tücher und schon bleiben auf 4 m nur noch 12 - 14 fL. Das ist akzeptabel hell, aber eben eher an der unteren Grenze. [Beitrag von FoLLgoTT am 24. Mrz 2016, 16:08 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#247

erstellt: 24. Mrz 2016, 18:16

|

|||||||||||||||||

|

Andere Frage: bei Dolby Vision im Kino ist ja von 31 fL die Rede. Weiß jemand, ob da eigentlich nur der Weißpunkt erhöht wurde oder ob er tatsächlich bei 14 fL geblieben ist und der Rest für Spitzlichter reserviert ist? Ich habe bisher nur gelesen, dass der Weißpunkt generell angehoben wurde. Ein Bild mit 36 fL und >1.000.000 : 1 konnte ich übrigens schon vor Jahren bei einem Bekannten betrachten, der mit einem Barco 909 auf eine gekrümmten High-Gain-Leinwand projizierte. Bis auf die Artefakte durch den hohen Gainfaktor (Color Shift usw.) war das schon spektakulär. Und das mit stinknormalem SDR-Material. Neu ist das, was das Dolby-Kino kann, also nicht wirklich und spezielles Material benötigt man für einen hohen Kontrast auch nicht zwingend.  |

||||||||||||||||||

|

George_Lucas

Inventar |

#248

erstellt: 24. Mrz 2016, 18:29

|

|||||||||||||||||

|

Dolby hat den Weißpunkt auf 31 fL (108 Nit) erhöht, wenn für 2D-Kontent mit "Dolby Vision" projiziert wird. Für 3D-Filme sind es dort übrigens 14 fL. Das wurde uns so bei Dolby in London berichtet. |

||||||||||||||||||

|

Cine4Home

Gesperrt |

#249

erstellt: 24. Mrz 2016, 19:06

|

|||||||||||||||||

Tja, die Referenz ist wohl dann nur noch das Dolby Vision Original im Kino. Macht die Sache natürlich nicht einfacher. Ich vermute schon, dass die HDR-Version anders aussehen soll. Ganz einfach aus zwei Gründen: Erstens, sie sieht auf einem guten HDR-Fernseher auch anders aus und zweitens, die Hersteller wollen HDR ja auch verkaufen, und dafür muss man ja einen gewissen Wow-Effekt erzielen.  Aufgrund dieser Problematik haben wir bei den ersten Sehtests immer versucht, "neutral" zu beurteilen, welcher Bildeindruck dem wirklichen Seheindruck (also wenn man jetzt live im Film wäre) näher kommt. Und bei allen Teilnehmern war das Ergebnis immer die HDR Version. Das ist natürlich etwas subjektiv, aber es deckt sich definitiv mit den Zielen, die die Industrie proklamiert. Scheint also was dran zu sein, an dem HDR Hype

Ja, ich meinte den Zusammenhang: Das "alte" Gamma in Kombination mit 8 bit beeinträchtigt den Spielraum in mittleren und höheren Helligkeiten immens, weil es im "wichtigen" Teil nicht genügend Abstufungen gibt. Das Gamma ist dafür nicht optimal genug, weil es nicht auf unsere Augen, sondern alte Röhrentechnik optimiert ist. Daher hat man das Limit ja auch auf 100 Nits gesetzt. Nun sind die Fernseher aber schon seit Jahren drei- bis fünfmal so hell, wodurch das Gamma eben nicht mehr richtig passt. Das kommt erschwerend hinzu. Theoretisch könnte man das natürlich mit einer höheren Bittiefe ausgleichen, aber das würde beim herkömmlichen Gamma 14bit erforderlich machen, um gleichwertige Ergebnisse zum 10bit HDR Gamma zu erzielen. Das wäre extreme Verschwendung und die Ressourcen hat man gar nicht. Von daher ist der Wechsel zu einem Betrachter-optimierten 10/12bitGamma der wesentlich intelligentere Weg.

Ja, das sollten wir, denn die HDR Fernseher haben auch nur dynamische "Beleuchtungstricks", um den Dynamikumfang zu erhöhen. Ihr nativer Panel-Kontrast ist nur ein Bruchteil(!) des JVCs Kontrasts. Ausnahme ist vielleicht OLED, aber das ist ja wieder etwas lichtschwach für HDR.

Also die 32fl reichen definitiv aus, um auch Spitzenlichter glaubwürdig hell erscheinen zu lassen. Klar, je größer die Leinwand, desto mehr Licht braucht man. Und wahrscheinlich sieht es mit 50fL noch besser aus, aber als zu dunkel würde ich >30 nicht bezeichnen. Dolby sieht das ja zum Glück auch so.

Also, die "idealen" Maximalwerte von Dolby sehe ich persönlich etwas kritisch. Bei TVs mag das ja noch passen (obwohl, 10,000cd/m²???  ) , aber mal ehrlich: Wenn man beim Beamer 300 bis 3000 FL anstreben würde und es gäbe schnelle Wechsel von dunkler Nachtszene auf helle Tagesszene, dann wird das doch schmerzhaft, selbst wenn nur Spitzenlichter diese Helligkeiten erreichen sollen. ) , aber mal ehrlich: Wenn man beim Beamer 300 bis 3000 FL anstreben würde und es gäbe schnelle Wechsel von dunkler Nachtszene auf helle Tagesszene, dann wird das doch schmerzhaft, selbst wenn nur Spitzenlichter diese Helligkeiten erreichen sollen.

Vereinzelt liest man, dass das Bluray Konsortium nur für Highlights mehr als 1000fl empfiehlt. Das klingt schon realistischer.

Ja genau, und eigentlich sehe ich bei Bildbreiten bis 3m nur hier das wirkliche Defizit der Digitalbeamer. Je dunkler und kontrastschwächer eine Filmszene, desto wichtiger der Schwarzwert. Das sieht man selbst bei einem JVC.

Das sind wir uns nicht ganz einig. Beim direkten Vergleich gewinnt die HDR Version immer deshalb, weil die hellen Spitzenlichter einen so deutlichen Kontrastunterschied zu den Schattenpartien desselben Bildes erzeugen. In Echt haben wir diesen hohen "Inbildkontrast" auch und das HDR Bild simuliert dies wesentlich authentischer nun. Der Unterschied bei verschieden hellen Szenen kommt hinzu, liegt aber glaube ich gar nicht so im Fokus der Hersteller, wahrscheinlich auch, weil es dann zu anstrengend für unsere Augen wird, ständig neu adaptieren zu müssen.

Ja, ich glaube Dolby definiert mit den knapp über 30fL Schon den Sweetspot, ab dem es richtig Spaß macht. Ich beobachte aber persönlich immer wieder, dass die Bildgröße im Verhältnis zum Sichtabstand durchaus mit unserem Helligkeitswahrnehmen interagiert. Daher auch die unterschiedlichen Toleranzen zwischen Beamer und TV. Gruß, Ekki [Beitrag von Cine4Home am 24. Mrz 2016, 19:16 bearbeitet] |

||||||||||||||||||

|

Cine4Home

Gesperrt |

#250

erstellt: 24. Mrz 2016, 19:08

|

|||||||||||||||||

Ich glaube, Nils wollte vielmehr wissen, wo dieser Weißpunkt effektiv eingesetzt wird. Das wird in der Tat von Dolby nicht richtig kommuniziert. Und auch bei den 4K Blurays scheint man da sich ja nicht einig zu sein,. Genau das erzeugt ja die Diskussionen, die wir gerade haben. Gruß, Ekki [Beitrag von Cine4Home am 24. Mrz 2016, 19:09 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#251

erstellt: 24. Mrz 2016, 21:50

|

|||||||||||||||||

Ja, aber im Gegensatz zu der Blende erhöht sich durch Local Dimming der Kontrast immerhin lokal begrenzt, wenn auch nicht pixelgenau. Die Blende dagegen könnte man als "Global Dimming" bezeichnen.

Ja, das halte ich auch für unsinnig. Ich denke, ohne die Einbeziehung des Umgebungslichts und des vom Bild eingenommenen Blickwinkels ist kein sinnvoller Helligkeitsbereich definierbar. 0,0001 Nits bringen auf einem TV auch keinen Mehrwert, wenn neben dem Sofa die Stehlampe leuchtet und das Panel reflektiert. Genausowenig werden 3000 fL im schwarzen Heimkino sinnvoll sein.

Das kam vielleicht falsch rüber. Mit verschieden hellen Szenen meinte ich eher ganze Filme. Also z.B. ein Horrofilm, der ständig dunkel ist, profitiert von einem Kontrast, der nach unten hin erweitert ist, enorm. Ganz im Gegensatz zu einem hellen Liebesfilm. Da ist der Nutzen deutlich geringer.

Nach meiner Erfahrung wirkt ein großes Bild, das einen großen Blickwinkel einnimmt etwas heller als ein kleines, das einen kleinen Blickwinkel einnimmt und dieselbe Leuchtdichte besitzt. Was ich mich die ganze Zeit frage: wieso ist für die normale UHD Blu ray (also nicht HDR) überhaupt noch das alte Potenzgamma 2,2 aus BT.709 vorgesehen? Zumindest ist das in BT.2020 so spezifiziert. Abwärtskompatibilität kann es eigentlich nicht sein, weil der Farbraum für alte Anzeigegeräte sowieso umgerechnet werden muss. Da hätte man auch gleich einheitlich das ST 2084-Gamma übernehmen können... [Beitrag von FoLLgoTT am 24. Mrz 2016, 21:51 bearbeitet] |

||||||||||||||||||

|

Cine4Home

Gesperrt |

#252

erstellt: 24. Mrz 2016, 22:12

|

|||||||||||||||||

Aber immerhin in 10bit  Wahrscheinlich, weil das HDR Thema erst später aufkam? BT2020 ist doch schon aus dem Jahr 2012, oder? Ursprünglich war die 4K Bluray sogar in 709 Farbraum geplant, dann hat man aber wohl gemerkt, dass die Auflösung alleine nicht genug zieht. Gruß, Ekki [Beitrag von Cine4Home am 24. Mrz 2016, 22:13 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#253

erstellt: 24. Mrz 2016, 22:18

|

|||||||||||||||||

Stimmt, wobei ca. 1 Bit für den größeren Gamut draufgeht. Aber immerhin gilt das nur für die Farbdifferenzkanäle und betrifft nicht den Lumakanal.

Ja, das würde das allerdings erklären. |

||||||||||||||||||

|

Master468

Inventar |

#254

erstellt: 24. Mrz 2016, 23:37

|

|||||||||||||||||

Wenn wir uns nicht gerade im Bereich hoher Maximalleuchtdichten bei geringem bis mäßigem Umgebungslicht bewegen, ist ja schon eine Gamma 2.2 Tonwertkurve - also erst recht die neuen Definitionen für HDR - in den Tiefen eigentlich schon zu dicht. Zum Vergleich kann man ganz gut die unter diesen Bedingungen (typisch insbesondere auch für Anwendungsfelder der grafischen Industrie) deutlich perzeptivere Helligkeitsverteilung in CIELAB heranziehen. Sie verläuft in den absoluten Tiefen linear. Gerade mit der bislang üblichen 8bit Quantisierung täte man sich also mit den neuen HDR-Tonwertkurven unter diesen Umständen (SDR) gar keinen Gefallen. Überdies definiert Rec.709 ja auch gar keine Tonwertkurve in der Wiedergabe (EOTF), sondern bezieht sich rein auf die Aufnahmeseite (und selbst das wird in realen Bearbeitungsprozessen mehr oder weniger hinfällig sein). Im Hinblick auf die stark unterschiedlichen Wiedergabebedingungen im Heimbereich ist das auch nicht ganz abwegig. Kurz: Ich verstehe die Intention, aber für SDR Inhalte ist die Kodierungseffizienz mit "traditioneller" Gammakorrektur höher (durch die 10bit natürlich ziemlich entschärft) und das Handling zumindest für nicht HDR Wiedergabegeräte einfacher. Gruß Denis [Beitrag von Master468 am 25. Mrz 2016, 01:46 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#255

erstellt: 25. Mrz 2016, 10:10

|

|||||||||||||||||

Für TVs mit Umgebungslicht mag das zutreffen. In einem schwarzen Heimkino sieht das wieder anders aus. Laut  diesen Folien reichen mit der BT.1886-Kurve und einem Weißpunkt von 1000 Nits in den unteren Stufen ca. 10 - 11 Bit aus (sehr dunkle Realbilder), um die Wahrnehmungsschwelle zu unterschreiten. Ausgehend von 100 Nits dürften das etwas weniger sein, vielleicht 8 - 10 Bit. diesen Folien reichen mit der BT.1886-Kurve und einem Weißpunkt von 1000 Nits in den unteren Stufen ca. 10 - 11 Bit aus (sehr dunkle Realbilder), um die Wahrnehmungsschwelle zu unterschreiten. Ausgehend von 100 Nits dürften das etwas weniger sein, vielleicht 8 - 10 Bit.Ich kann daraus jedenfalls nicht ablesen, dass 8 bit mit einer Potenzfunktion von 2,2 bei einer kontrastreichen Projektion schon zu dicht kodiert sind. Oder habe ich dich falsch verstanden?

Ja, das ist richtig. Und es wird fast immer auf eine Potenzfunktion hin kalibriert. |

||||||||||||||||||

|

Cine4Home

Gesperrt |

#256

erstellt: 25. Mrz 2016, 10:44

|

|||||||||||||||||

Klar, ein Full Backlight HDR Fernseher ist überlegen, keine Frage. Zumindest, solange man genau rechtwinklig drauf schaut  Aber mit dem JVC macht HDR definitiv auch Spaß. Ich werde mal nach Ostern größere Bildbreiten (3-5m) damit testen und schauen, wann es zu dunkel wird. Auch den Einfluss von Streulicht (Wohnzimmer) muss man untersuchen.

Ich habe die Woche den neuen Sony VW5000 mal auf einer 2,5m Leinwand betrieben: 3400 Lumen, also rund 100ftl mit einem nativen Kontrast von 15,000:1. Und ganz ehrlich: Außenaufnahmen wirkten richtig, richtig hell, das hatte schon was. Aber: Beim Schnitt von dunkler Szene auf Tageslichtszene war das für meine Augen echt grenzwertig, kurzzeitig fühlte ich mich da geblendet. Wer will das denn zigmal in einem Spielfilm haben? Also ich nicht, man kann es mit dem Realismus auch übertreiben. Man darf nicht vergessen: Ein Spielfilm ist im Vergleich zum realen Leben ein Zeitraffer, da wechseln Tag & Nacht im Minutentakt und nicht im 24h/Tagestackt. Daran sind unsere Augen nicht gewöhnt.

Ja das ist so und wie gesagt: Hier sehe ich den eigentlichen Nachteil der Digitalbeamer gegenüber dem Full LED Backlight HDR TV. Da mit HDR viele Details sehr nahe an Schwarz liegen, kann damit eine super realistische und fein nuancierte Durchzeichnung erzielt werden. Auf dem HighEnd TV wirkt das dann richtig nach "Nacht", wie live. Beim Digitalbeamer hingegen stört das nicht perfekte Schwarz und die subtilere HDR-Durchzeichnung hebt sich nicht so stark ab, wie bei dem relativ steilen 8bit HD-Powergamma. Das habe ich auch in meinem HDR Praxistest Artikel thematisiert, aber dazu konnten wir kein aussagekräftiges Foto machen, deshalb ist das vielleicht leider untergegangen. Theoretisch wäre es vielleicht eine Lösung, das HDR-Gamma unten ein klein wenig anzuheben, aber das geht mit dem JVC nicht so einfach. Aber ich werde da noch recherchieren.

Jo das ist so, aber da gibt es keine wirklich fundierten Untersuchungen zu. Dabei ist das eigentlich ziemlich naheliegend: Wenn die Leinwand unser komplettes Blickfeld ausfüllt, kommt eine größere Lichtmenge in unsere Augen, als bei einer kleineren Bildfläche. Wieder der VW5000: Vor zwei Wochen Championsleage Spiel mit Kumpel blickfeldfüllend auf 5m Leinwand geguckt (ja ich weiß, dekadent sowas  ). Und bei voller Helligkeit fanden wir das beide schon fast unangenehm. ). Und bei voller Helligkeit fanden wir das beide schon fast unangenehm. Wer die Möglichkeit hat, mal folgenden Test machen: Mal nachts so nahe vor eine LED Videowall (1000 bis 5000nits machen die Dinger, also das, was jetzt für TVs empfohlen wird) stellen, dass das Blickfeld komplett ausgefüllt ist. Dann umdrehen Richtung Nacht und zeit timen, die man braucht, um wieder was zu sehen. Dann wieder zur Videowall drehen.  Klingt zwar albern, aber dann erkennt Ihr, was diese Helligkeiten bei Leinwandgrößen bedeuten würden und ob Ihr das wirklich daheim so wollt. Klingt zwar albern, aber dann erkennt Ihr, was diese Helligkeiten bei Leinwandgrößen bedeuten würden und ob Ihr das wirklich daheim so wollt.  Gruß, Ekki [Beitrag von Cine4Home am 25. Mrz 2016, 11:03 bearbeitet] |

||||||||||||||||||

|

FoLLgoTT

Stammgast |

#257

erstellt: 25. Mrz 2016, 14:56

|

|||||||||||||||||

|

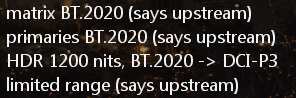

Hier mal was anderes zu dem Thema. Es kursieren ja einige wenige HDR-Demos im Netz. Mit MPC-HC und MadVR kann man sie abspielen und zur Laufzeit auf einen beliebigen anderen Farbraum konvertieren. Die Gammakurve aus ST 2084 wird von madVR ebenfalls angewendet. Folgendes findet sich in den Metadaten, die der Decoder an madVR sendet: "Exodus Draft":  |

||||||||||||||||||

|

Master468

Inventar |

#258

erstellt: 25. Mrz 2016, 18:42

|

|||||||||||||||||

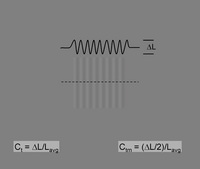

Wir müssen zunächst vor allem die zugrundeliegenden Modelle betrachten. Die HDR Tonwertkurve (ST 2084) lehnt sich ja an das Barten-Modell an, wobei die DICOM Tonwertkurve die unmittelbarste Umsetzung sein dürfte (entsprechende Erkentnisse werden natürlich auch im Bereich des professionellen Farbmanagement der grafischen Industrie gewürdigt). Hier geht es vor allem um gleichabständige Helligkeitsdifferenzen bei isolierter Farbmusterbetrachtung. Das repräsentiert echte Bildinhalte höchstens sehr mittelbar. Natürlich ist aber auch ein kompletter Graukeil synthetisch, insofern stehen wir vor einer Problematik, die sich im Grunde nur durch eine noch präzisere Quantisierung (12bit+ pro Farbkanal) völlig auflösen lässt (ab einem gewissen Punkt könnte man dann sogar völlig linear arbeiten). Hinzu kommt, dass beispielsweise in den von mir angedeuteten Anwendungen der grafischen Industrie völlig andere Betrachtungsbedingungen vorliegen. Typische Einsatszenarien hier sind Abmusterungen nach ISO 3664, die eine Beleuchtungsstärke von 500 (P2) bzw. gar 2000 Lux (P1, für kritische Anwendungen z.B. im Drucksaal) fordern. Das führt zu korrespondierenden Leuchtdichten von 160 cd/m² für den typischen Einsatz am Arbeitsplatz (P2) bis hin zu rund 640 cd/m² für die P1-Bedingung. Bei Verzicht auf Abmusterungen von Vorlagen unter Normlicht werden gemeinhin deutlich geringere Leuchdichten im Bereich von 100-140 cd/m² genutzt, abhängig von den Umgebungsbedingungen. Unter den beschriebenen Bedingungen liefert die L* Tonwertkurve (entspricht der Helligkeitsachse in CIELAB) die visuell gleichabständigste Gradation. Das kann man gut mit zwei hardwarekalibriebaren Monitoren überprüfen, die die jeweilige Tonwertkurve auch verlustfrei reproduzieren können. Im direkten Vergleich wird dann deutlich, dass schon eine Gamma 2.2 Tonwertkurve in den absoluten Tiefen zu dicht ist. Das verstärkt sich mit der DICOM Charakteristik (sie ist für einen Bereich von 0,05 bis 4000 cd/m² definiert - für reale Wiedergabegeräte wird dann ein entsprechender Ausschnitt gewählt und entsprechend gemappt). Selbst bei fehlendem Umgebungslicht ändert sich daran vergleichsweise wenig, insofern ist das schon auf andere Bereiche gut übertragbar. Aber: Ich beziehe die Gleichabständigkeit hier auf die gesamte Helligkeitsachse. Unter den Bedingungen einer isolierten Betrachtung (vgl. Bild), bei denen das Auge Zeit zur Adaption hat, verschieben sich die Toleranzen.  Natürlich kann auch die L* Charakteristik keine Wunder vollbringen. Bei 8bit pro Farbkanal ist so ein Graukeil keinesfalls völlig übergangslos - allerdings sind die Sprünge gleichverteilt. Mit 10bit pro Farbkanal lassen sich durchweg (auch Gamma 2.2 oder DICOM) sehr ansprechende Resultate erzielen. Hier reicht die Marge also aus, um auch bei ungünstigeren "Gesamtverteilungen" kaum Abstufungen sichtbar werden zu lassen. Gerade bei HDR gewinnt aber eine Definition nach ST 2084 (oder auch DICOM) enorm an Bedeutung, da wir hier selbst gegenüber meinem Drucksaal-Beispiel deutlich gesteigerte Maximalleuchtdichten berücksichtigen müssen und das so repräsentierte HDR Material ja die Spitzenhelligkeiten nur sehr vereinzelt abruft. Trotzdem möchte man eine gute Differenzierung in den Tiefen und Lichtern des "Arbeitsbereiches" mit deutlich geringerem Dynamikumfang - und hier stoßen die bislang üblichen Konzepte (tradiert aus CRT Charakteristika und Druckkennlinien) an ihre Grenzen. Gruß Denis [Beitrag von Master468 am 25. Mrz 2016, 19:20 bearbeitet] |

||||||||||||||||||

|

BiGOnE

Ist häufiger hier |

#259

erstellt: 25. Mrz 2016, 19:11

|

|||||||||||||||||

|

Bei MadVR und HDR ist aber die Frage wie gut die Konvertierung ist, er reicht die HDR Daten leider nicht einfach durch. Bei meinen X5000 habe ich auf jeden Fall noch nie die Meldung HDR - Yes gehabt. Und wenn ich die Demos abspielen, hauen die mich auf jeden Fall nicht vom Stuhl. |

||||||||||||||||||

|

volschin

Inventar |

#260

erstellt: 25. Mrz 2016, 19:17

|

|||||||||||||||||

|

Welchen HDR-fähigen Zuspieler benutzt Du denn? |

||||||||||||||||||

| ||||||||||||||||||

|

|

||||

| Das könnte Dich auch interessieren: |

|

HDR - High Dynamic Range bei Projektoren Cale am 14.08.2015 – Letzte Antwort am 14.08.2015 – 5 Beiträge |

|

ECHTES dynamisches HDR Tone Mapping für Projektoren mit madVR annaundflo am 25.03.2019 – Letzte Antwort am 18.05.2024 – 2646 Beiträge |

|

Kommen dieses Jahr noch 4K Beamer mit HDR heraus? Projektormann am 25.04.2015 – Letzte Antwort am 14.01.2016 – 47 Beiträge |

|

Neue HDR Gamma Kurven für Sony 4K Projektoren morot am 22.06.2020 – Letzte Antwort am 27.04.2022 – 13 Beiträge |

|

HDR-Gammakurven für Sony-Projektoren mit dem ARVE-Tool Omardris am 19.11.2017 – Letzte Antwort am 17.01.2018 – 265 Beiträge |

|

Sony VW260 / VW360: Übersicht zu HDR, 4K, FI und Tuning binap am 10.05.2018 – Letzte Antwort am 18.05.2022 – 31 Beiträge |

|

Sony VPL-VW290ES VS JVC N5 Dynamic HDR deckard2k7 am 28.10.2021 – Letzte Antwort am 29.10.2021 – 2 Beiträge |

|

Projektoren für HDR richtig einstellen - u. a. mit diesen Testbildern George_Lucas am 20.04.2016 – Letzte Antwort am 20.09.2018 – 70 Beiträge |

|

AutoCal für Sony-Projektoren - ein erster Schritt Omardris am 03.03.2019 – Letzte Antwort am 28.03.2019 – 37 Beiträge |

|

LG LED Projektoren HW300G & HW300Y Erni127 am 03.03.2011 – Letzte Antwort am 14.02.2017 – 36 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in Projektoren / Beamer der letzten 7 Tage

- JVC DLA-NP5 / NZ7, NZ8, NZ9

- Epson EH-LS11000 & EH-LS12000 2021 Laser, 3LCD, Shift 4k

- Deckenhalterung Beamer- Bild verkehrt herum?

- Wo Steckdosen in der Decke platzieren für meinen Beamer?

- XGIMI Horizon Pro Beamer Gespräche, Tipps und Tricks

- Beamer macht Lila bild pls help

- Fleck INNEN in der Linse!

- EPSON EH-TW7000 und EH-TW7100: 4K PRO-UHD Nachfolger der EH-TW6700 und EH-TW6800

- nebula capsule max mit apps bespielen

- Sony Beamer 2022 - VPL-XW5000ES - ( VPL-XW6000ES in Amerika ) / VPL-XW7000ES

Top 10 Threads in Projektoren / Beamer der letzten 50 Tage

- JVC DLA-NP5 / NZ7, NZ8, NZ9

- Epson EH-LS11000 & EH-LS12000 2021 Laser, 3LCD, Shift 4k

- Deckenhalterung Beamer- Bild verkehrt herum?

- Wo Steckdosen in der Decke platzieren für meinen Beamer?

- XGIMI Horizon Pro Beamer Gespräche, Tipps und Tricks

- Beamer macht Lila bild pls help

- Fleck INNEN in der Linse!

- EPSON EH-TW7000 und EH-TW7100: 4K PRO-UHD Nachfolger der EH-TW6700 und EH-TW6800

- nebula capsule max mit apps bespielen

- Sony Beamer 2022 - VPL-XW5000ES - ( VPL-XW6000ES in Amerika ) / VPL-XW7000ES

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder930.662 ( Heute: 7 )

- Neuestes Mitgliedds1178

- Gesamtzahl an Themen1.563.462

- Gesamtzahl an Beiträgen21.826.200